Deepfake er et generelt begreb, der dækker over syntetisk indhold, hvor aspekter af virkeligheden ændres på en måde, hvor det ikke er tydeligt for modtageren. Vi kender en del til det fra ansigter, der byttes ud. Læs fx mere i Kforum-artiklen her. Audio deepfakes er oftest baseret på en tekst-til-tale-teknologi – også kaldet syntetisk tale – hvor man skriver sætninger, som programmet læser op med den stemme, der er til rådighed. Syntetisk tale kan også blot være en generisk robot, der læser en tekst, som VoiceOver-programmet på en iPhone. Deepfake er anderledes. Det refererer generelt til kombinationen af deep learning og fake; altså, hvor en bestemt metode for at bygge algoritmer anvendes til at skabe noget nyt indhold, der manipulerer med virkeligheden. Audio deepfake er så en syntetisk stemme, der lyder helt som din, min og præsidentens eller rockstjernens. Det er conversational AI på en tilpasset og fake måde. Læs mere på Kforum om syntetiske personer

her og

her.

Dronning Elizabeth II læser "God Save the Queen" af Sex Pistols. Internetironi.

Ud fra et lingvistisk synspunkt er det ret interessant at se, hvor avancerede programmerne er blevet. En stemme er som bekendt bestemmelig ud fra en ret kompliceret sammensætning af udtale, fonetiske elementer af ord, overordnet prosodi i sætningskonstruktioner, ordvalg, tur-interne pauser, intonation, udstrækning eller sammentrækning af ord, betoning, rytme, toneleje, osv., osv. Nu kan en computerkode pludselig gennem en masse træning skabe noget, der ligner. Det er imponerende. Se de nyeste, overbevisende eksempler her.

Disse audio deepfake-teknologier kan lave alle slags kendte stemmer.

Hvad er teknologien bag audio deepfake?

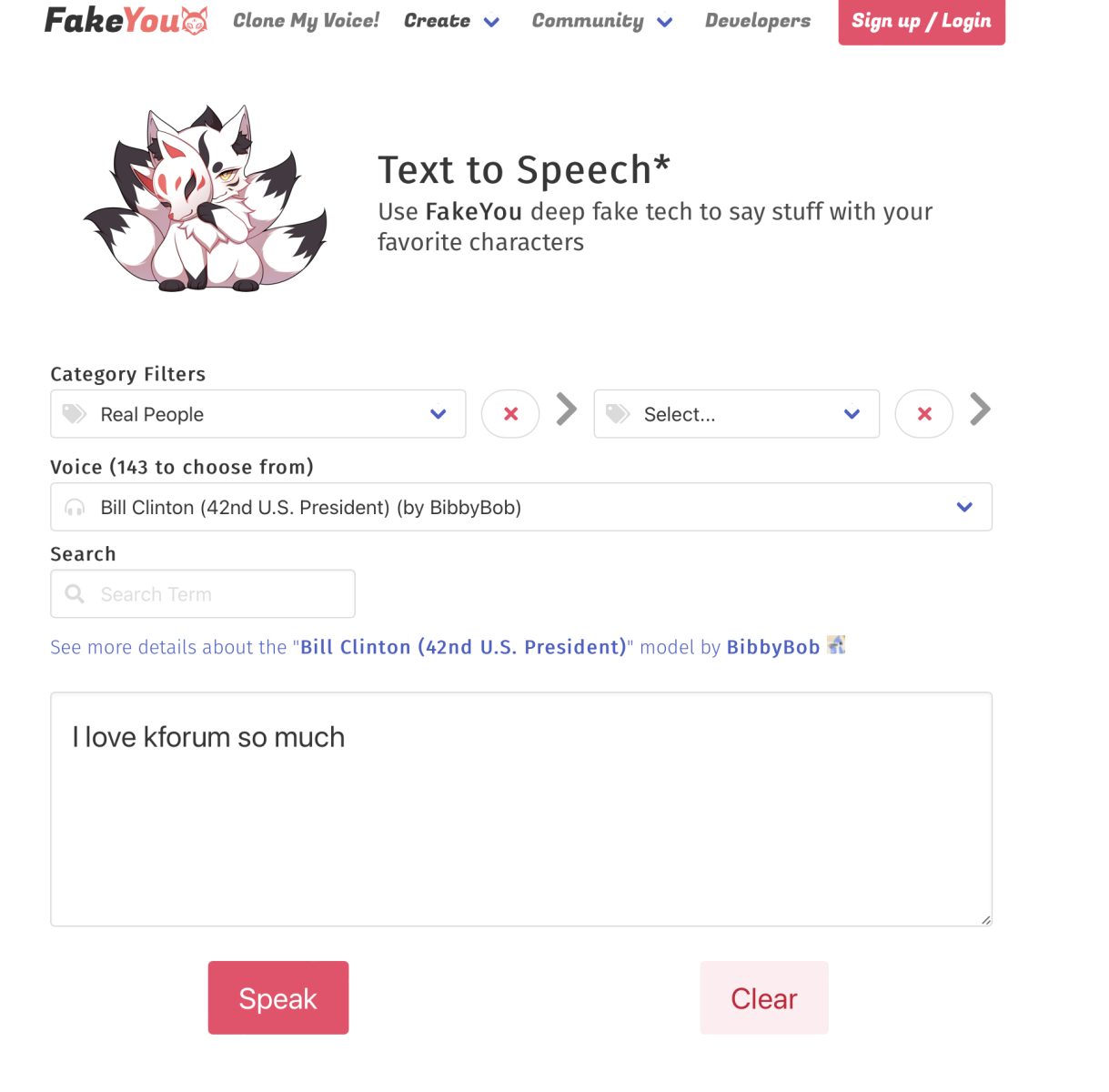

Der findes en lang række servicer på markedet allerede for alle, som vil udforske kunstig tale. Tag fx Resemble AI, der er en tekst-til-tale- og deepfake-lydsoftware, der kan skabe lyd af høj kvalitet uden at kræve store mængder data. Man kan bruge værktøjet til at træne Resemble til at efterligne din egen stemme eller uploade forudindspillede klip. Klippene kan selvfølgelig også være af en andens stemme. Se eksempel her: