I Danmark kan man låne penge ”på sit glatte ansigt”, hvis udlåneren ved, hvem man er. På engelsk kan man godtage noget på ”face value”, hvis man er tryg ved den person, der udtaler sig. Begge udtryk viser betydningen af ansigtet, når vi etablerer tillid i relationer. Vi genkender hinanden, og vi stoler på ”et kendt ansigt”.

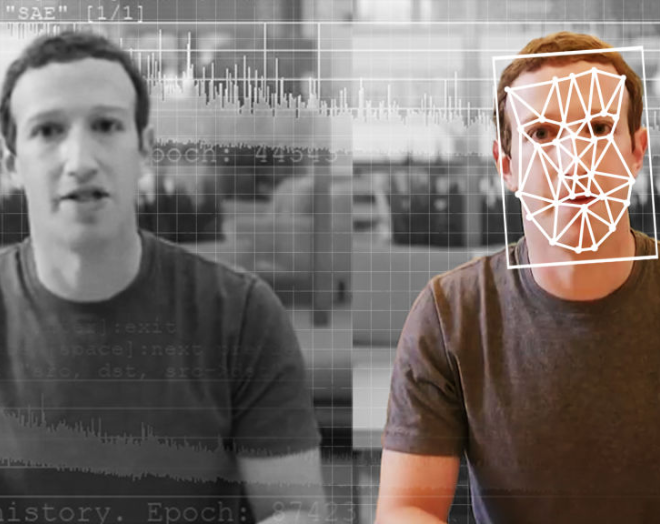

Men i en ikke så fjern fremtid kan dit ansigt stjæles og sættes ind i andre sammenhænge end dem, du rent faktisk befinder dig i. Det skyldes fænomenet deepfake, som kombinerer kunstig intelligens (såkaldt deep learning) med falske nyheder, typisk i videoer, der er meget overbevisende.

For privatpersoner bliver det sjovt. Du kan se dig selv som præsident, filmstjerne eller rockmusiker i videoklip. Men for kendte mennesker, politikere eller Hollywoodstjerner, der bliver sat ind i sammenhænge, de aldrig har været i, er det anderledes alvorligt.

Demokratiet er i fare. Med deepfakes er det sandsynligt, at tiltroen til nyheder og levende billeder fuldstændig forsvinder.

Hvordan fungerer det egentlig?

Deepfake er kunstig intelligens, der består af to algoritmer i det, som kaldes en GAN (generative adversarial network). Den første algoritme lærer, hvad der får noget til at se ægte ud. Den bliver tildelt en hel masse data og får så besked om, hvilke data der ser mest rigtige ud. På den måde lærer den efterhånden, hvad der skal til, for at en video af en person ser ægte ud.

Den anden algoritme forsøger at snyde den første algoritme ved at lære, hvad der IKKE går igennem. For eksempel var der i starten mange udfordringer i deepfakes med øjne, der blinkede ”forkert”, og når algoritme nummer to så opdager, at det ikke fungerer, kører den løs på at løse præcis det problem.

Lige nu kan man for eksempel se på thispersondoesnotexist.com, som er mennesker, der er computergenereret, og altså ikke fotos af rigtige mennesker, at deres GAN har fået løst de fleste problemer med hår og ører, som i starten var rædsomme, men der er stadig udfordringer med skuldre og nakke. Kort sagt bliver algoritmerne, der hjælper med at konstruere disse falske videoer bedre og bedre. Og det giver problemer.

Allerede nu, i algoritmernes spæde vorden, bliver deepfakes brugt og misbrugt til alverdens forskellige ting.

Når velgørenhedsorganisationer bruger deepfakes

Så sent som for en uge siden kom en fransk velgørenhedsorganisation med fokus på bekæmpelse af AIDS under beskydning, fordi de i en kampagne brugte en deepfake-video af Donald Trump. I den siger han, at ”kampen mod AIDS er ovre”.

Debat om at bruge deepfake-film med Trump i kampagne for bekæmpelse af AIDS:

Videoen var – som det fremgår – ikke særligt godt lavet, og den var da også, ca. 40 sekunder inde, forsynet med oplysning om, at der var tale om falske nyheder med det formål at sætte fokus på kampen mod AIDS. Alligevel rejste videoen spørgsmålet: ”Er det ok, at bruge deepfakes?”. Kritikerne lagde vægt på, at troværdigheden for alle nyheder er på spil, mens fortalerne mente, at det var ”ret let at gennemskue”, at kampagnefilmen var en forfalskning.

Når en kinesisk app ejer dit ansigt

Det er ikke første gang, deepfakes skaber debat. For en måneds tid siden tiltrak den kinesiske app ZAO sig stor opmærksomhed. I løbet af et døgn blev appen den mest populære i den kinesiske app store. Via en serie af selfies lader ZAO brugerne sætte deres egne ansigter ind i filmklip – for eksempel for at se sig selv som Leonardo DiCaprio – og som stjerner i populære musikvideoer.

Her kan du se, hvordan ZAO-appen fungerer:

Der skulle kun gå et par dage, før appen havde skabt enorm debat. ZAO blev nemlig kritiseret for en passus i brugerbetingelserne, hvor der med småt stod, at hvis du bruger appen, er de intellektuelle rettigheder til dit ansigt ZAOs ejendom.

Formuleringen ændrede ZAO senere, fordi brugerne protesterede, men truslen er reel. Når du uploader dit ansigt til en tjeneste, der har som hovedformål at manipulere levende billeder, så må du regne med, at også data om dit ansigt fremover kan lækkes, hackes og misbruges.

Du kan foreløbig ikke uploade billeder af andre end dig selv i ZAO (hverken af din chef eller en præsident) for alle forsøg på at uploade et gemt foto (frem for at tage et foto med kameraet) kræver, at du bekræfter med en selfie. Alligevel er appen allerede kommet under hård beskydning for at være et alvorligt skridt ud på glidebanen, hvor vi ikke aner, hvem og hvad vi kan stole på.

Hollywood elsker deepfakes

Deepfakes er ikke et nyt fænomen. Der har til alle tider været imitatorer og skuespillere, der har kunnet spille andre mennesker overbevisende. Fantastisk som Gary Oldman kan ligne Churchill, eller som Helen Mirren kan spille dronning Elizabeth ll. Men hele humlen i skuespil er, at det blot ligner en kendt person. Og det er vi opmærksomme på. Vi forveksler aldrig spillefilm med dokumentarudsendelser.

Den amerikanske imitator Jim Meskimen har i nedenstående kombineret sin evne til at efterligne stemmer og ansigtsudtryk med deepfake-teknologi. (Prøv at tjekke, hvor mange kendte amerikanske skuespillere, du kan genkende i hans deepfake):

Og i denne video fra Sham00K kan du se, hvordan teknologien bag fungerer, og hvilke kendisser Jim Meskimen har “lånt” ansigterne fra:

Der er ingen tvivl om, at avancerede deepfakes fremover kommer til at imponere os, når vi går i biffen. I instruktør Ang Lees nyeste film Gemini Man, som fik premiere i oktober, spiller Will Smith en 51-årig agent, der jages af en klon, der er ham selv som 23-årig. Hele filmen lægger op til kamp mellem de to versioner af Will Smith, og det er ærlig talt svært at se, hvem af dem der er computergenereret eller sminket ældre/yngre:

Prisen på den falske, unge udgave af Will Smith, som er bygget af det new zealandske firma Weta Digital, der har Peter Jackson, som skabte Ringenes Herre som medstifter, løber op i mere end 10 mio. dollars. Der er lagt mange måneders arbejde i at udvikle karakteren, og der spekuleres derfor i, om det har været dyrere at skabe Will Smith digitalt, end det har været at betale hans løn.

I takt med, at deepfake-teknologien udvikler sig eksponentielt, falder prisen på ”falske” skuespillere til Hollywoods store glæde. Kort før premieren på Gemini Man blev denne korte udgave af The Matrix offentliggjort. Her er Keanu Reeves erstattet med selvsamme Will Smith. Videoen er lavet med gratis-softwaren DeepFaceLab:

På YouTube findes der allerede tutorials til DeepFaceLab-softwaren. En af videoerne, der lærer dig, hvordan du bruger softwaren, er set mere end 15.000 gange og at dømme efter kommentarerne, er der masser af udviklere, der sidder derhjemme og prøver sig frem med at skabe gode overbevisende deepfakes.

Kendte skuespillere bruges til deepfakes i pornoindustrien

Et af de områder, hvor den nye teknologi allerede bruges flittigt, er i pornoindustrien. Da cybersikkerhedsfirmaet Deeptrace tidligere i år undersøgte, hvor mange deepfake-videoer de kunne finde online, fandt de ca. 15.000, hvoraf 96 % er porno.

Allerede i 2017 kom de første apps frem, hvilke blev brugt til at sætte kendte skuespilleres ansigter ind i pornofilm. Der lød selvfølgelig et ramaskrig fra de kendte. I dag praler nogle af tjenesterne af at have flere hundrede pornofilm med Emma Watson eller Scarlett Johannson og andre prominente skuespillere tilgængelige.

Dog har andre sites som Pornhub og Twitter siden lovet, at de vil fjerne deepfake-film fra deres kanaler, men de har tilsyneladende meget svært ved at leve op til deres løfter. For nylig påviste BuzzFeed, at der på Pornhub fortsat er masser af deepfakes, og nogle af dem sågar er med reklamer. Bagmændene tjener altså penge på at misbruge kendte menneskers ansigter i porno.

Nogle i pornoindustrien har forsøgt sig med et argument om, at kvinder, der udsættes for hævnporno, vil få lettere ved at benægte, at det er dem på film og billeder, da de fremover kan påstå, at alle videoerne er deepfakes. Andre i debatten fastholder, at det for de fleste kvinder (kendte eller ukendte) er en kæmpe ydmygelse og forbundet med stor psykisk smerte at få delt nøgenbilleder ufrivilligt – også når de ikke er ægte.

I Californien vedtog man i februar 2019 en ny lov, der gør det forbudt at lave deepfakes uden samtykke fra personen, hvis ansigt man bruger. Bøden kan være op til 150.000 dollars, og formålet er især at beskytte Hollywoodstjerner. Samtidig besluttede en række platforme – herunder Reddit, der ellers har været hub for udveksling af både software og deepfake-filer – at forbyde deepfakes.

Men som sædvanlig halter både lovgivningen og især mulighederne for at gribe ind og fjerne indhold fra nettet efter den teknologiske udvikling. Af samme grund har Facebook, Microsoft og Amazon sammen med en række universiteter lavet en deepfake challenge, hvor de opfordrer udviklere til at hjælpe med løsninger til at bekæmpe deepfakes. Løsningerne skal naturligvis bruges til at holde platformene fri for deepfakes via automatisering, frem for at mennesker skal sidde og overvåge manuelt.

Deepfakes er farlige for demokratiet

Den største udfordring bliver selvfølgelig ikke film i biografen, hvor vi alle ved, at vi skal ind og snydes til at tro, vi befinder os i fremtiden eller i det vilde vesten. Udfordringen med deepfakes bliver nyhedsudsendelser og muligheden for at manipulere med det, politikere og meningsdannere siger, på nye overbevisende måder.

Blandt andet har vi allerede nu i amerikansk politik set nogle af de værste eksempler på deepfakes, både manipulationer med billeder og video. I maj måned dukkede der fx et videoklip op med demokraten Nancy Pelosi, hvor man satte hastigheden på lyden ned, hvilket fik hendes stemme til at lyde, som om hun enten var syg eller påvirket (og dermed mindre kompetent).

Den redigerede Nancy Pelosi-video forklaret:

Debatten handlede efterfølgende i høj grad om konsekvenserne af manipulationen – at folk faldt for klippet og faktisk troede på, at hun var syg eller fuld. Det hjalp selvfølgelig ikke, at Trump også delte en video af Pelosi – hvilken muligvis ikke var deepfake, men bare var klippet sammen for at få hende til at fremstå usammenhængende.

Det interessante er dog, at de fleste eksperter i debatten er enige om, at problemet med deepfake ikke bliver manipulationen. Problemet er, at vi ender med ikke at tro på noget som helst.

I forvejen er det sådan, når vi taler politik, at vi tror på det, vi nu engang er overbevist om, er sandt. Et eksempel er Pizzagate, hvor der i valgkampen mellem Hillary Clinton og Donald Trump var en falsk historie i omløb om, at Hillary Clinton skulle være involveret i en børnepornoring under et pizzeria i Washington. I dag (21. oktober 2019) viser undersøgelser ifølge DR’s udenrigskorrespondent Steffen Kretz, som blev interviewet på P1, at 46 % af de republikanske kernevælgere stadig mener, ”at der må være noget om snakken”, når det gælder Pizzagate. Vi er med andre ord svære at overbevise om, at vi er blevet snydt.

Når de historier, vi gerne vil tro på, bakkes op af video, bliver de endnu mere overbevisende. For når vi opbygger tillid, bruger vi vores sanser. Vi tror mere på det, vi selv har set og hørt. Det betyder også, at nogle kommentatorer mener, at det største problem med deepfakes ikke bliver, at vi tror på falske videoer, men at vi ikke tror på de ægte. ”Hvordan ved du, at den video, du viser mig som bevis for, at det du siger, er sandt, ikke også er manipuleret?”. Deepfakes kan altså forvirre os voldsomt og gøre samfundsdebatten vanskeligere.

I stedet for at have en debat om indholdet og om, hvorvidt vi er enige med det, Nancy Pelosi siger, får vi alenlange diskussioner om, hvorvidt det overhovedet er hende, der taler. Spørgsmål om, hvem der er afsender, og hvilken interesse de har i at fremstille en sag fra den ene eller den anden vinkel, bliver pludselig mere vigtige end selve sagen.

Hvis du af og til er træt af debatter om ”tonen” eller om, hvem der er mest krænket i en eller anden sag, så bare vent til alle nyhedsudsendelserne handler om, hvem der påstår, at aftenens historie fra i går bare var en avanceret deepfake.

Så hvad skal vi gøre for at undgå, at deepfake-teknologien ødelægger vores tillid til hinanden?

1) Gør det ulovligt at stjæle andre menneskers ansigter, stemmer og kropssprog.

Hvis din stemme og dit ansigt bliver stjålet og misbrugt uden dit samtykke, så skal det være muligt for dig at gøre krav på at få materialet fjernet. Vi kan måske kopiere lovgivningen fra Californien?

Lige nu er alle platformene selv ude at sige, at de skam ikke vil tillade deepfakes. WeChat i Kina har for eksempel allerede forsøgt at stoppe ZAO, og både Twitter og Pornhub har for længst været ude at sige, at deepfakes er uacceptable. Udfordringen er, at ingen af platformene reelt har teknologiske metoder til at opdage og fjerne deepfakes.

Som allerede nævnt har Facebook derfor – i samarbejde med Microsoft og Amazon og en række universiteter – udskrevet en konkurrence om, hvem der kan skrive en effektiv kode, der kan opdage deepfakes. De har sat 10 mio. dollars af til indsatsen, og spørgsmålet er, om det kan løse den del af problemet.

Et andet problem er håndhævelse. Hvis vi vedtager, at deepfakes uden samtykke er ulovlige her i Danmark (som i Californien), så får det ikke den store effekt, med mindre vi udstyrer dansk politi med superkræfter til at undersøge anmeldelser og handle, når loven overtrædes. Formodentligt skal regler indføres på EU-niveau og meget gerne også globalt for at batte. Måske det skal være en menneskerettighed at andre ikke må stjæle dit ansigt? Uanset hvad, så har vi det sædvanlige problem: Internettet er globalt og meget besværligt at styre.

2) Vi er nok nødt til at sætte farten lidt ned i nyhedsjournalistikken.

Når platforme som Facebook og Twitter ikke opdager deepfakes, og når de samtidig konstant bliver sværere at gennemskue, så bliver nyhedsjournalistik, hvor man faktisk går til kilden og afventer, at man kan finde ud af, om noget er rigtigt eller ej, endnu vigtigere.

Jeg kan selv rigtig godt lide at se Presselogen på TV 2 om søndagen, men det nytter jo ikke noget, at programmet skal vare seks timer, fordi der uge efter uge bliver tvivl om, om noget er deepfake eller korrekt.

3) Vi er nødt til at finde og linke til de oprindelige kilder.

Et af problemerne med nyheder er, at den oprindelige kilde ofte fortaber sig i det uvisse. Hvem delte først en deepfake – eller hvor opstod den oprindelige historie om Pizzagate? Detektivarbejdet vanskeliggøres af, at medier kun sporadisk linker til oprindelige kilder.

I dag er kilderne ofte Twitter, Facebook eller Instagram, hvor historier løber stærkt og efterfølgende samles op af journalister, som ikke altid har tid til at tjekke den oprindelige afsender. Med hensyn til Pizzagate viste det sig, at de oprindelige rygter var plantet i debattråde på Reddit – formodentlig af russiske robotter. At være dygtig til at grave i, hvor en video, som man mistænker for at være deepfake, kommer fra, kan blive en vigtig journalistisk kompetence.

4) Uddannelse i kildekritik.

Vi er nødt til som brugere af digitale medier at være kildekritiske og veluddannede. Det er for nylig kommet frem, at de unge slet ikke er så superdigitale, som nogle gik og troede. Bare fordi man er god til at snappe eller lægge billeder på Instagram med de rigtige hashtags, er det ikke det samme som, at man har styr på den digitale verden, man lever i.

Det er også kommet frem, at ældre mennesker er dem, der deler langt de fleste fake news, fordi de simpelthen ikke kan gennemskue de falske afsendere, og hvor let det er at snyde med billedmanipulation. Så når det lige om lidt bliver endnu lettere at blive snydt, er det altså ret vigtigt, at vi alle sammen bliver bedre til at gennemskue, hvad vi kigger på, og til at være reelt kildekritiske.

5) Uddannelse i at være menneske.

Det bliver afgørende, at vi forstår, hvor dårligt vi mentalt er udstyret til alt det her fup og svindel. Vores hjerner er ikke bygget til deepfakes og dyb mistro. Vores hjerner er bygget i urtiden, og vi havde (og har stadig) brug for at kunne etablere tillid til andre mennesker. En teknologi, der forvirrer vores syns- og vores høresans – som ellers er vores superkræfter, når vi skal afgøre, hvem vi kan stole på – er en trussel mod vores sameksistens med andre mennesker og skal derfor tages meget seriøst.

Artikler til videre læsning:

Amsterdambaseret sikkerhedsfirma Deeptrace, der jagter deepfakes: