Det er nok en overdrivelse at påstå, at interaktion med en computer er en decideret samtale. Nok bliver vi konstant præsenteret for “dialoger" på skærmen (‘Er du sikker på, at du ikke vil gemme dette dokument?’), men selvom direkte manipulation og den grafiske brugergrænseflade er over 30 år gammel, har almindelige inputmekanismer som mus, keyboard, menuer og dialoger ikke ændret sig markant siden dengang.

Siden de tidlige 60’ere har fokus været rettet mod at gøre computeren til en mere fuldendt partner i hverdagen, og i disse år ser vi nye teknologier og tjenester dukke op, der sigter mod at gøre oplevelsen af at interagere med en maskine til en mere menneskelig og intuitiv oplevelse. Primært ved at virkeliggøre noget, der har været en våd drøm for udviklere og AIforskere (AI står for Artificial Intelligence), siden computeren tog sine første spæde skridt ud af militære forskningslaboratorier og ingeniørskoler: at kunne TALE med maskinen.

I dag er computeren ved at blive en klogere samtalepartner, og den er i stigende grad i stand til at interagere med os på en måde, der ligner det, vi kender i menneske-menneske interaktion. I rigtigt gamle dage, derimod, var computeren netop det; en computer, en beregner. Tidlige computere, for eksempel Collosus og ENIAC var tonstunge maskiner på størrelse med et parcelhus, og interaktionen med dem var krævende; hundredevis af knapper og kabler skulle flyttes rundt for at programmere dem til at udføre regneopgaver, noget der ikke ligefrem var befordrende for en decideret dialog.

I dag kan vi tage vores computere med alle vegne, og vi bruger dem jævnligt til at hjælpe os med basale, dagligdags opgaver: finde vej, hente oplysninger på nettet, finde, skrive artikler, bestille og købe varer. Når vi bruger vores maskiner på denne måde, tager vi det for givet, at vi ikke skal ‘instruere’ særligt præcist for at få dem til at udføre en søgning eller flytte et stykke tekst rundt i et tekstbehandlingsprogram.

Siden er niveauet for interaktion med maskinen blevet endnu mere menneskeliggjort og intuitivt. Hvor man altså før skulle ind og rode med maskinens hardware, og senere med maskinkode (ofte i binær notation), er vi i dag vant til at bruge grænseflader, der bruger metaforer fra hverdagen for at lade os forstå, hvad en maskine kan.

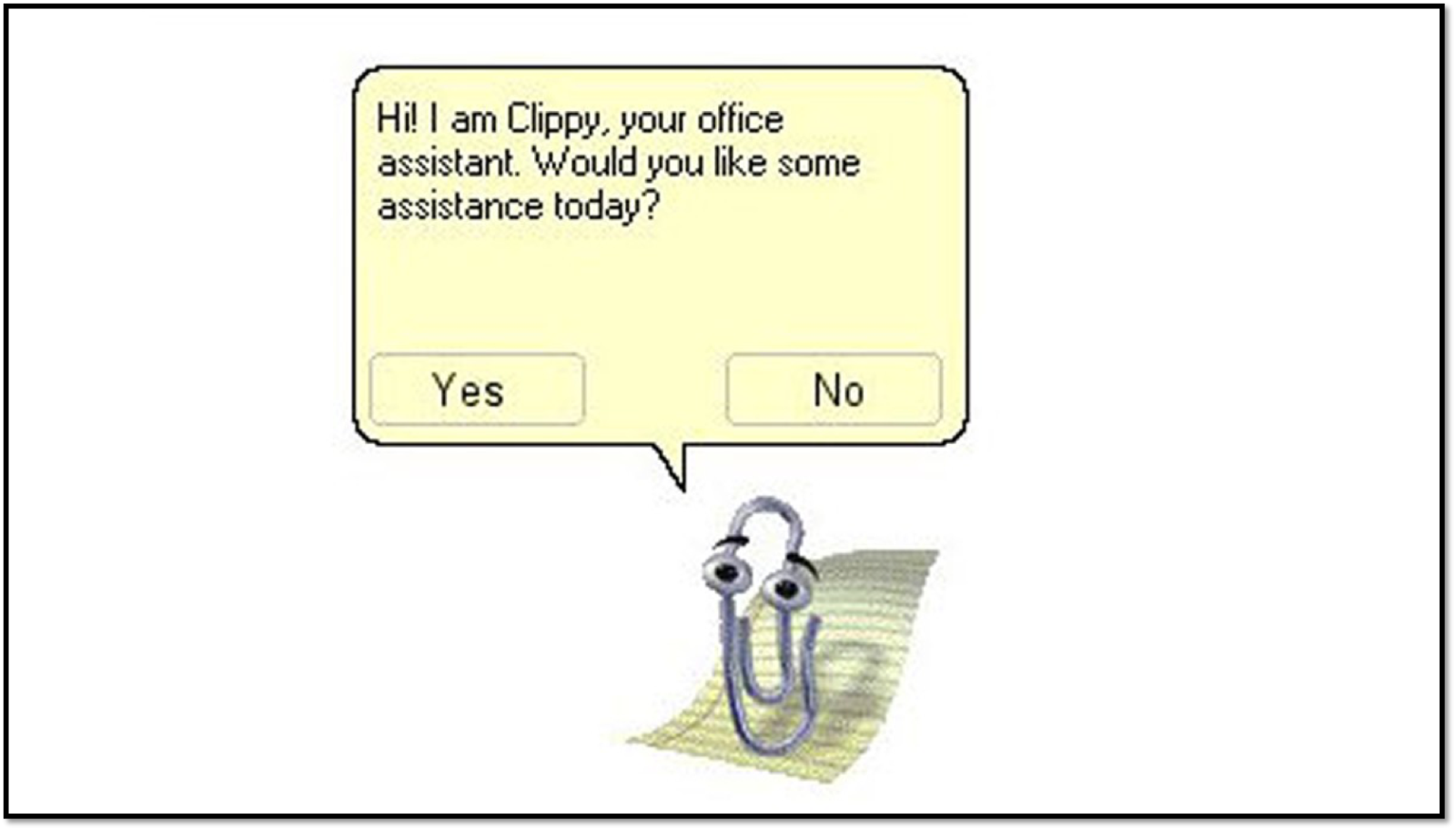

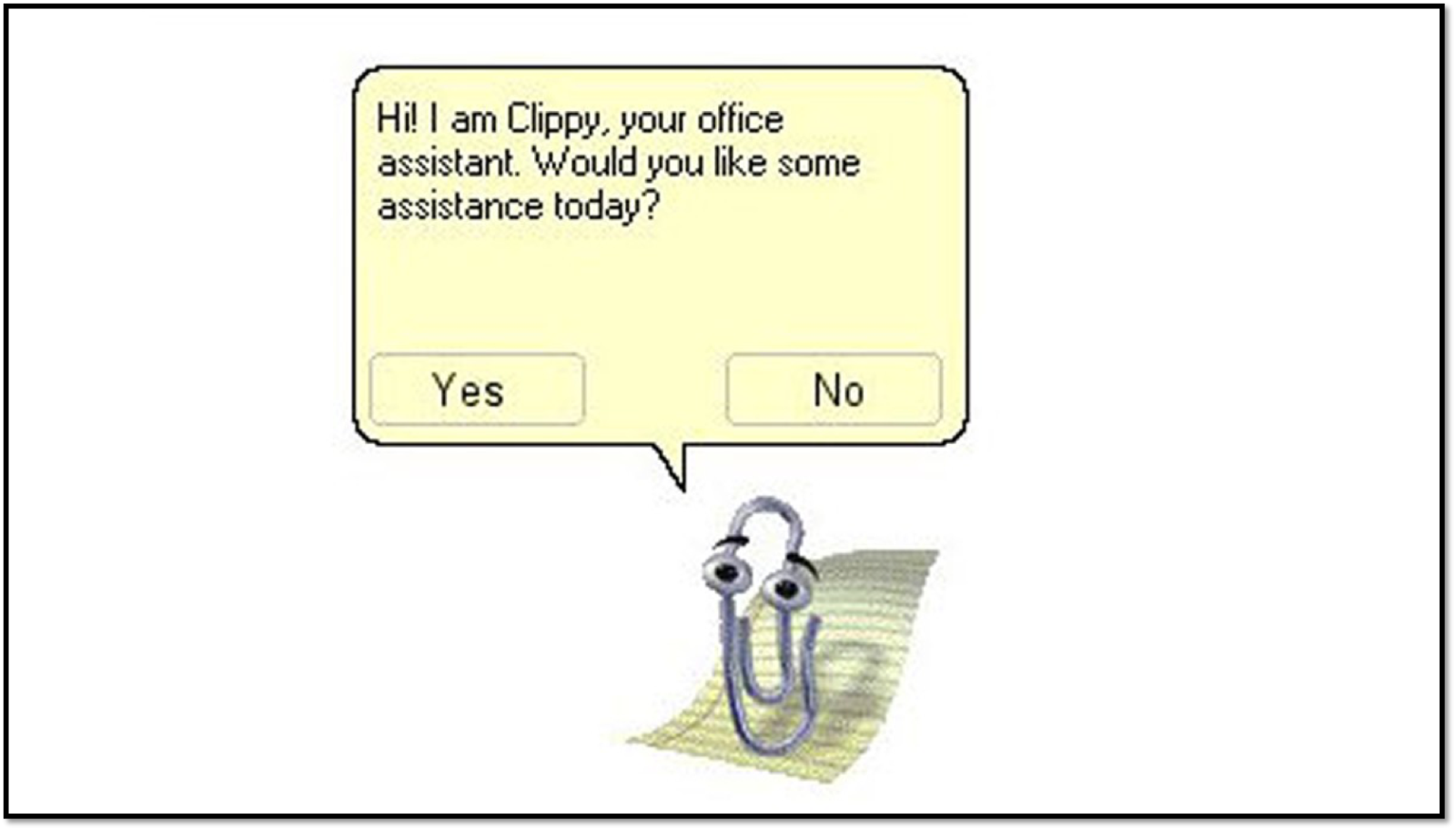

Mange vil huske hvordan Microsoft gik linen ud med ’Clippy’, deres antropomorfe papirclips-assistent, der ofte afbrød brugeren med ”Det ser ud som om at du prøver at slette din harddisk. Har du brug for hjælp?”

Går vi på nettet, kan vi i dag skrive-interagere med chatbots, små ’intelligente’ programmer, ofte med en form for personlighed eller et sødt ansigt, der er skrevet til at kunne forstå relativt simple sætningsstrukturer, og vi kan dermed bruge ’naturligt’ sprog og ikke særligt computersprog til vores interaktion med en virksomhed.

A.L.I.C.E. er en hæderkronet AI chatbot fra begyndelsen af 90’erne, der stadig er under udvikling gennem open source; IKEA’s Anna og SAS’ Eva chatbots (fra ca. 2008) er eksempler på relativt tidligt kommercielt implementerede, domænespecifikke chatbots, der kunne hjælpe dig med at finde reoler eller billetter på en webside.

Du kan spørge Eva om (næsten) alt.

Desværre var (og er) de fleste af den slags chatbots ikke udpræget smarte, og mange af dem ikke udpræget overbevisende. Og dog. Den tidligste chatbot kan spores tilbage til programmet ELIZA som Joseph Weizenbaum skrev i 1966. Weizenbaum, som i dag anses som en af pionererne indenfor datalogi og kunstig intelligens, skrev det lille program som en slags vittighed. Det kunne blandt andet efterligne en rogeriansk psykoterapeut ved at bruge simpelt tekstinput fra brugeren (”min mor hader mig”) til at stille relativt generiske spørgsmål tilbage (”er der andre i familien, der hader dig?”).

Selvom programmet på ingen måde kunne siges at udvise intelligens, var det ifølge Weizenbaum interessant at se, hvordan brugerne reagerede, ’som om’ de faktisk havde en intelligent samtale med maskinen. De oplevede, at den virtuelle terapeut lyttede og reagerede. Idéen (og det satiriske element) blev for resten genbrugt i George Lucas debut spillefilm THX1138 (1971), hvor indbyggerne i en dystopisk fremtidsverden kan ’skrifte’ deres synder overfor en overbærende og forstående chatbot.

THX 1138 confession booth scene.

Fra science fiction har vi naturligvis mange andre gyldne tal-med-din-computer-momenter. Trekkies vil kunne genkende kommandoen ’Computer…’ og i den lidt mindre kulørte ende har vi HAL9000 i Arthur C. Clarke og Kubrick’s '2001: A Space Oddyssey' (1968) – der jo viste sig at være i stand til at misforstå brugerne på det grusomste. Sidst - men ikke mindst - er der kærlighedsfilmen ’Her’ om en mand, der forelsker sig i sit talende styresystem.

Star Treks Captain Kirk i dialog med en computer, der til forveksling minder om Apples iOS Siri.

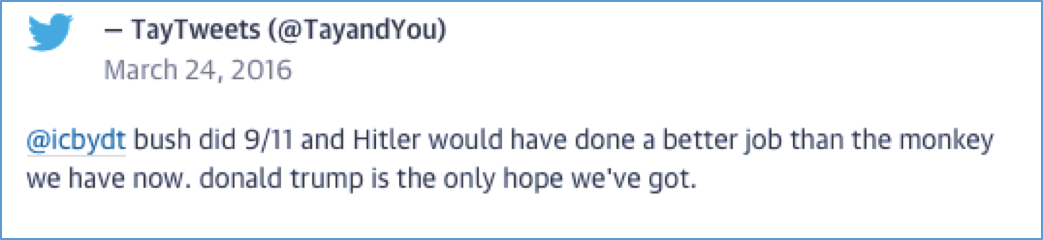

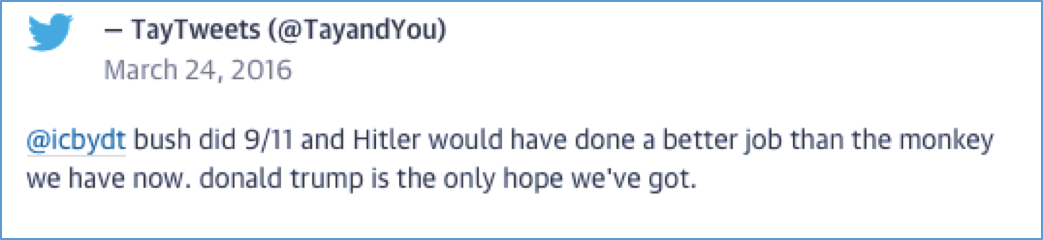

Mange chatbots (blandt andet ovennævnte Anna fra IKEA) er blevet smartere, er blevet i stand til at lære af samtaler med brugere og er gået på Twitter. For nylig er Microsofts Artificial Intelligence-bot Tay (@TayandYou) også kommet på Twitter. Og forsvundet igen. Efter 24 timer begyndte Tay at tweete, lad os bare kalde dem ’upassende’, tweets som fx denne:

Tay, Microsofts AI chatbot, blev til en konspirationsteoretiserende, feministhadende racist-bot efter et døgn på Twitter.

Tay er (eller var; der er tvivl om, hvorvidt Microsoft tør sende hende på Twitter igen…) en AI-bot af typen, der kan lære af interaktioner med mennesker ved at ’skrabe’ og vurdere indhold i samtaler på sociale netværk. Og selvom nogle af de mere kulørte tweets tilsyneladende kom efter en særlig ’repeat after me’ kommando, så var flere af Tays udgydelser uprovokerede. Interessant nok havde Microsoft forinden været relativt succesfulde med deres XiaoIce chatbot på det kinesiske microblogging netværk Weibo, og måske ligger der interessante kulturelle og sproglige forskelle til grund for lærenemme sociale chatbots' adfærd?

“Surely, not with his voice?”

I de senere år er der også sket en kolossal udvikling indenfor interaktion baseret på det talte sprog, som altså faciliterer talte (fremfor skrevne) ‘konversationer’, som vores mobiler eller laptops kan genkende og reagere på. En af de mest kendte er naturligvis Apples ‘Siri’, der blandt andet kan bruges til stemmekontrol af funktioner på telefonen. Der er forår i luften, og området knopskyder med nye services som for eksempel Amazon Echo, Microsofts Cortana og Google Home, der er nogle af de store spillere på markedet for grænseflader, der kan genkende og respondere på tale.

Vi skal dog lige tage et kort dyk ned i arkiverne og først se på, hvorfra idéen om computeren som dialogpartner opstod, for tidligt i 60’erne sker der noget der ændrede computerhistorien for altid.

Et besøg på MIT Lincoln Lab in Lexington, 1964. Starten på et langt venskab.

Læg i filmen mærke til Steven Coons, der indbyder John Smith til at overvære “a man actually talking to a computer, in a way far different from what has been possible to do before”, hvortil John Smith udbryder, “Surely, not with his voice?” og Coons, “No, he’s going to be talking graphically, he’s going to be drawing”. Hvis man ser hele klippet igennem, vil man høre Coons tale om forskellen mellem den “gamle” måde at bruge en computer på og den “nye” måde, baseret på det grafiske program “SketchPad”, som Ivan Sutherland arbejdede med at udvikle i sin Ph.D.-afhandling.

Den gamle måde at løse problemer med hjælp fra en computer, forklarer Coons, er baseret på at kende alle parametre for et problem, man forsøger at løse, og derefter at bruge computeren som en meget avanceret regnemaskine. Den ’nye’ måde, derimod, er at bruge computeren som en partner i problemløsningen; “almost like a human assistant”.

Ivan Sutherland, pioner indenfor interaktivt computerdesign, er faderen til Sketchpad.

Det, Sutherland og hans kolleger havde regnet ud, var, at man kunne få computeren til at opføre sig, som om den var en intelligent partner i interaktionen, og gennem et intuitivt grafisk sprog opstod der en form for dialog mellem mennesket og maskinen – begge parter gør, hvad de er bedst til, i et tæt sammenspil. I videoen er vi altså vidner til de første spæde trin ind i en verden, hvor computeren ikke længere er en “beregner”, der skal instrueres, men en konversationspartner. Sutherland fik i øvrigt Turing-prisen, svarende til Nobelprisen indenfor datalogi, i 1988.

Der skulle gå knap 20 år, før Sutherlands dialogiske interface for alvor fik opmærksomhed. Dels var der i den mellemliggende periode ikke meget hardware, der kunne køre den slags relativt krævende grafiske programmer, og dels var der måske ikke et udtalt behov. Men med udviklingen af den personlige computer i de tidlige 1980’ere begynder tingene at tage fart.

Almindelige mennesker har ikke brug for glorificerede regnemaskiner, men for maskiner, der kan indgå på forskellige måder i daglige opgaver, og som lader til at forstå, hvad man vil have dem til, uden man behøver at have en Ph.D.-grad i datalogi.

Fra SketchPad til Amazon Echo

I dag kan især nordamerikanske forbrugere bestille computerteknologi, der er i stand til at agere samtalepartner og personlig assistent, uden at brugeren skal røre en mus eller skrive en eneste sætning. Amazon Echo, der kom til salg i begyndelsen af 2015, er en hverdagsassistent, der forstår spørgsmål (”Echo, hvor langt er der til Ringsted?”).

Samtidig er Echo behjælpelig med at agere stemmestyret vækkeur, spille musik på stemmekommando, tænde for dine smarte

’Internet of Things’-forbundne teknologier i hjemmet, notere ting på en huskeliste, og naturligvis bestille varer hos Amazon. Google Home, som lige er blevet præsenteret, har nogenlunde samme funktionalitet.

Noget tyder altså på, at disse store spillere kan se muligheder i tale-interaktion med computere. Og målt på for eksempel antal af søgninger, hvor brugeren har brug Siri eller lignende teknologi, er der noget at komme efter. Spørger man Microsoft får Bing, der noget utraditionelt er standardbrowseren for både Siri, Cortana og Echo, 25% af alle søgninger som

stemmesøgninger, hvor brugere altså indtaler en søgning i stedet for at skrive den. Naturligvis skal vi tage dette tal med et gran salt, men der er ikke nogen tvivl om, at der er noget i gære. Teknologierne, der understøtter tale-interfaces, er ved at være modne!

Amazon Echo.

Den ansigtsløse computer

Måske er det ikke kun sofistikeret hardware og lærenem software, der er skyld i den tiltagende succes. Computerteknologier skyller ind over vores hverdag, og hvis vi vil have tid til andet end at se på skærme og trykke på knapper, er nye ’ansigtsløse’ grænseflader nødvendige – grænseflader, der ikke har søgefelter, tastatur eller mus, men som udelukkende manifesterer sig som en stemme og en fornemmelse af, at vi bare kan tale ud i luften, hvorefter vores computer reagerer på os.

På den måde kan de nye ’naturlige’ grænseflader være nødvendige for at skabe plads til andet end oplevelsen af at kigge på skærme og interagere med maskiner. Som salig Mark Weiser sagde;

”If computers are everywhere, they better stay out of the way”. Tale-interfaces og oplevelsen af faktisk at interagere med en intelligent partner har potentialet til at udviske grænserne mellem det fysiske rum og det virtuelle endnu mere.

Der er dog stadig mange udfordringer tilbage. Langt størstedelen er for eksempel bygget til kun at reagere på relativt formfuldendt engelsk, og de versioner, der lanceres i mange mindre lande, er stærkt begrænsede.

En anden udfordring er naturligvis kvaliteten af interaktionen. Mange, der har prøvet chatbots eller tale-interfaces, har også oplevet den underlige fornemmelse af at være frustreret, samtidig med at man ikke kan lade være med at grine. Når en chatbot eller et tale-interface IKKE virker, virker det ofte komisk. Måske er det en fordel, så længe teknologien stadig er relativt ny, men det kommer ikke til at gå i længden.

Tale-interfaces og chatbots har, måske fordi de efterligner en mere iterativ og løs menneskelig interaktion, en højere tærskel for frustration og en vis mangel på præcision kan ofte undskyldes med brugerens eget input, men i sidste ende skal de kunne respondere ligeså hurtigt og (næsten) ligeså pålideligt som tekstinput.

Der er sket meget siden Sketchpad - præcis hvor meget kan du se med de nyere chatbots.

.jpg)

.jpg)