Modellen er den første officielle 100 % open-source AI-model. Mange små grupper af gør-det-selv-programmører har kreeret open-source replikaer af populære modeller, såsom DALL·E, men ingen har endnu opnået matchende kvalitet. Med SD har man endelig en AI-model i hænderne, som er både fri og stærk.

Hvem som helst kan downloade modellen, ændre i den, bygge oven på den og integrere den i andre applikationer.

Emad Mostaques ambition er at skabe accelereret fremdrift i feltet via radikal frihed og open-source filosofi, og indtil videre peger alt på, at det netop er det, der sker lige nu. OpenAI introducerede først for nyligt

outpainting til deres DALL·E API, mens brugeren

Lnyan blot skulle bruge en uge på at introducere en SD-drevet

app, der kan gøre præcist det samme.

Fordelene ved open-source teknologi er åbenlyse. Hvorfor har store virksomheder som OpenAI og Midjourney så valgt at fastholde deres modeller bag lukkede døre?

AI for de få

Hverken DALL·E, DALL·E 2, Midjourney, Imagen eller tekstgeneratoren GPT-3 er open source. Faktisk er hverken DALL·E eller Imagen

tilgængelige, medmindre man ansøger om adgang. Og når brugeren endelig tildeles adgang, så er det en speget og restriktiv udgave, brugeren møder.

OpenAI og Google er simpelthen bange for at slippe deres fulde modeller løs i befolkningen. Hvad vil det betyde, hvis enhver person på et splitskekund kan skabe et realistisk, deepfake billede af Joe Biden med en pistol i hånden, der peger mod et barn?

OpenAI, for eksempel, frygter for konsekvenserne ved at open source deres model, og derfor gør de alt, der står i deres magt for ikke blot at begrænse adgang til modellen, men også begrænse selve modellens evne til at skabe gråzone-indhold. OpenAI introducerede

for nyligt et nyt filter, der automatisk minimerer, hvad OpenAI opfatter som skadelige bias i de genererede billeder.

Hvis du skriver “videnskabsmand” i prompt-feltet i DALL·E-appen, så er der god sandsynlighed for, at det ikke er den prompt, modellen bag tæppet processerer. Bag tæppet vil prompten f.eks. omformes til “en marginaliseret videnskabsmand.” En del af OpenAI’s nye strategi er på usynlig vis at indsætte ord i din prompt, som de mener, vil minimere risikoen for bias i det genererede billede.

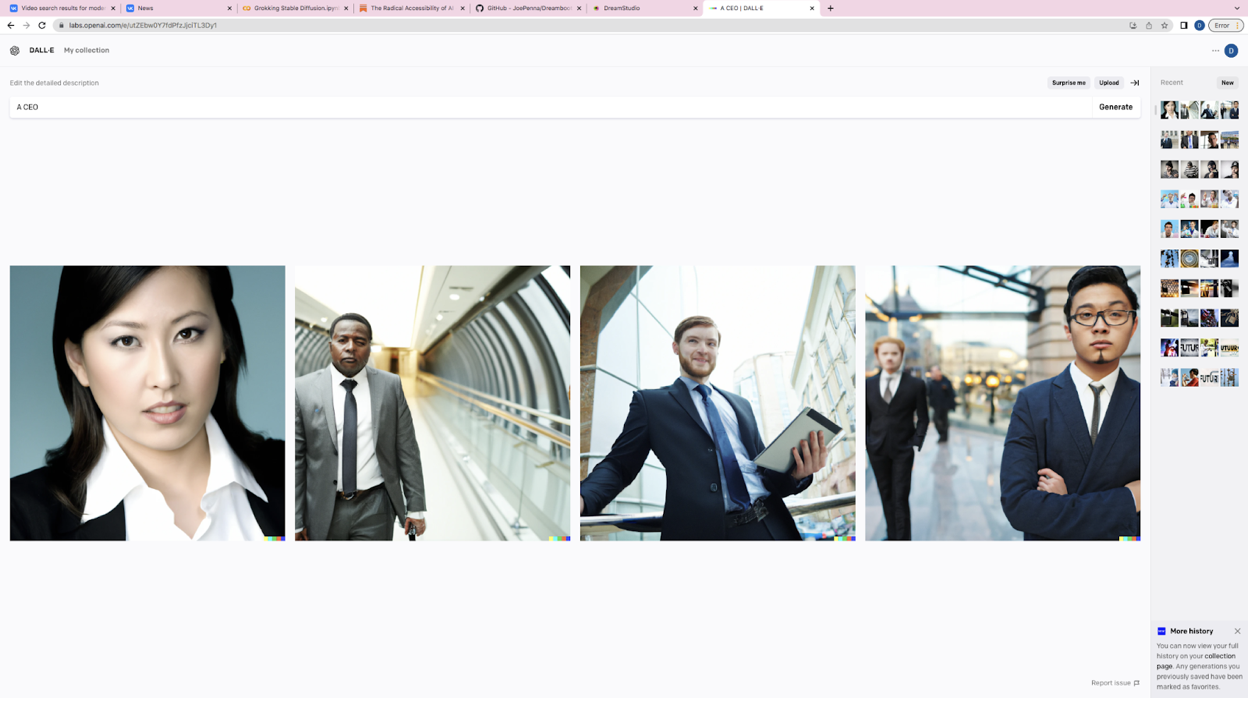

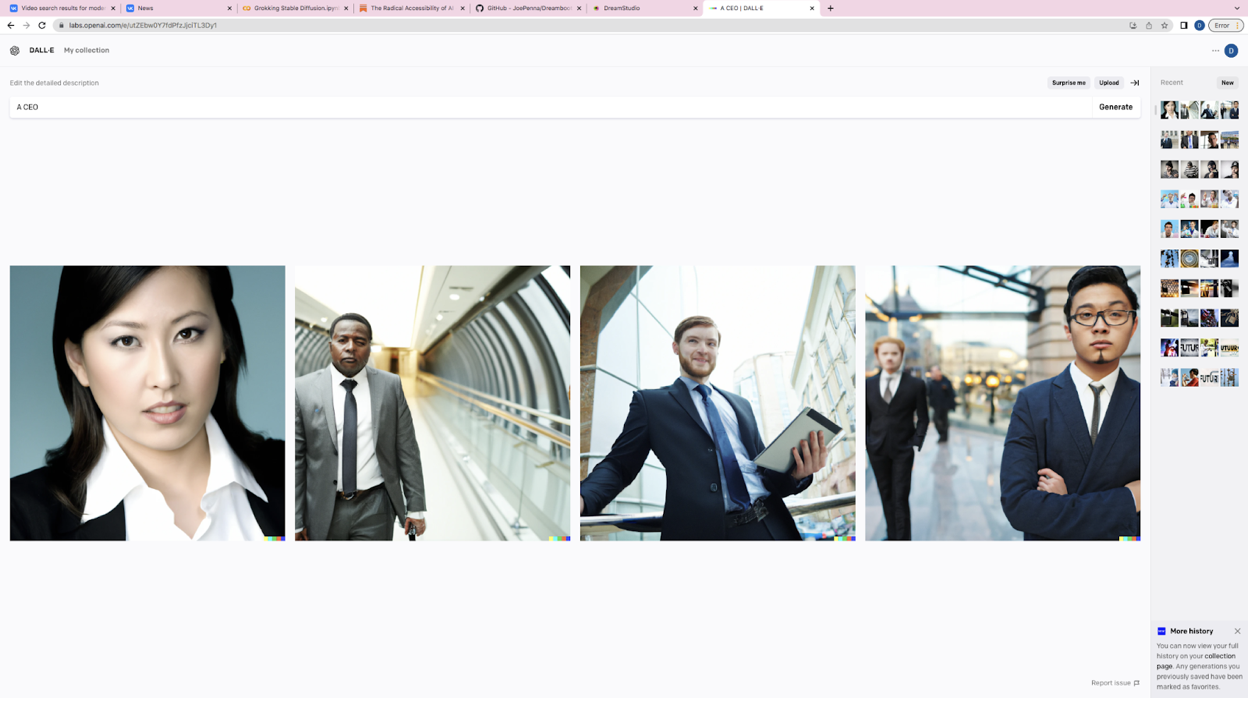

DALL·E 2’s bud på en CEO – hvilket ord er mon indsat i prompten?

DALL·E 2’s bud på en CEO – hvilket ord er mon indsat i prompten?

OpenAI’s kontrol over brugeren stopper ikke her. NSFW-billeder – altså Not Safe For Work-billeder – af f.eks. nøgne kroppe kan ikke skabes med DALL·E. Spørgsmålet er, hvor bølgen af kontrol stopper. I den mere ekstreme ende af den paternalistiske skala er den kinesiske tech-virksomhed Baidu, hvis egen AI-model,

ERNIE-ViLG, nægter at tegne et billede af “1911 revolutionen i Kina.” Modellen spiser i stedet brugeren af med sætningen: “The input content does not meet the relevant rules, please adjust and try again!”

Det kan virke paternalistisk, og det er det også, men OpenAI og Baidu ser paternalisme som en etisk nødvendighed.

Stability AI er gået i den modsatte retning. Her hedder filosofien “frihed under ansvar”, og nu er testen, hvad det leder til.

I en AI-billedgenerator uden restriktioner kan man eksempelvis indsætte prompten ISIS og få ovenstående resultat. Kilde: Vice.

I en AI-billedgenerator uden restriktioner kan man eksempelvis indsætte prompten ISIS og få ovenstående resultat. Kilde: Vice.

Frihed under ansvar

Ganske få dage efter offentliggørelsen af Stability Diffusion blev frihedens ansvar sat på prøve. På kort tid var der flere SD-NSFW subreddits, som badede sig i en stormflod af ulovlige billeder. Siderne blev hurtigt

bandlyst – ikke af Stability AI, men af Reddit. De var ganske enkelt fyldt med f.eks. pornografiske

billeder. Også på Discord blev der hurtigt oprettet NSFW-kanaler, f.eks.

Unstable Diffusion.

Emad Mostaque så det ikke som et problem. Det er okay at skabe NSFW-content, så længe det er på brugerens egen GPU, og så længe det ikke bryder med gældende lovgivninger eller licenser. I det første tilfælde var det Reddits politik, der spændte ben for friheden. Unstable Diffusion derimod eksisterer

stadig.

Stability Diffusion er en del af den såkaldte CompVis-

licens, som specificerer, at det er ulovligt at bruge modellen til ulovlig aktivitet. Ansvaret ligger hos forbrugeren. Hvis en bruger vælger at skabe 100 billeder af Jennifer Lopez ved siden af Hitler og sender ét til hende hver dag over 100 dage, så er det ikke Stability AI’s ansvar, men brugerens eget ansvar at leve med de potentielle konsekvenser.

På sin vis er den logik ikke ny. Det er forbudt at bruge Photoshop til at fjerne tøj fra unge piger, men hvis en bruger alligevel gør det, så er det brugeren selv, ikke Photoshop, som straffes. En privat bruger har allerede

implementeret Stability Diffusion i Photoshop, men det betyder givetvis ikke, at vi nu vil se en stormflod af kontroversielle, Photoshop-SD-skabte billeder. Nok er Stable Diffusion-modellen fri, men det er resten af verden ikke.

Adobe har allerede, ligesom flere andre virksomheder, skrevet under på det såkaldte

Content Authenticity Initiative, som forsøger at blåstemple autenticiteten af online content. Hvis Adobe på et tidspunkt vælger at implementere SD officielt i deres portefølje af programmer, så vil det givetvis være i en restriktiv “vanilla”-udgave med en række skræddersyede, Adobe-specifikke indholdsfiltre. Stability AI’s egen

online implementation af SD-modellen har endda integreret et NSFW-filter. Et meget sparsomt NSFW-filter findes også i selve modellens kode. Det filter kan dog let

fjernes.

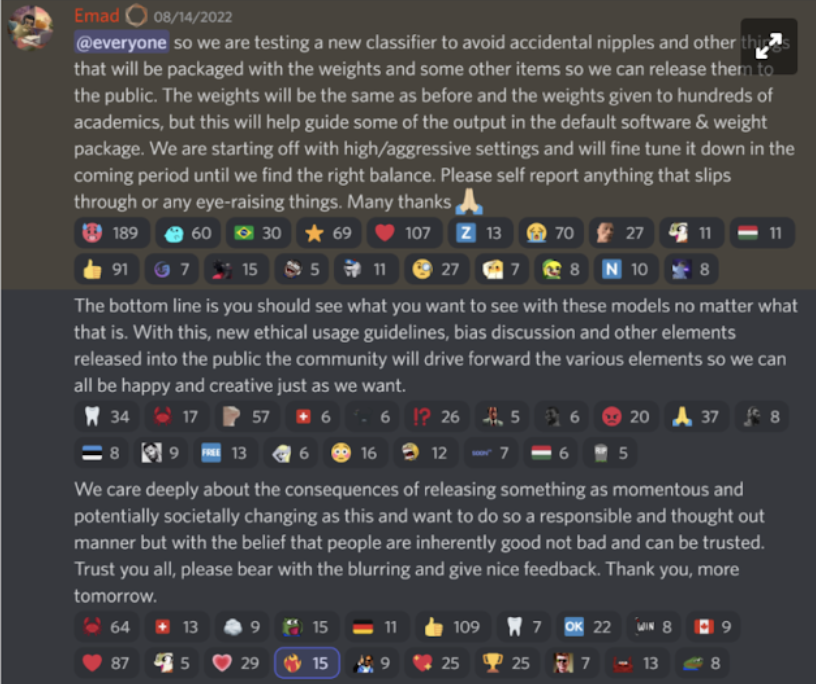

Ifølge Emad Mostaque er Stability AI’s rolle ikke at begrænse modellen. I stedet skal SD være startskuddet til et “intelligent internet”, hvor forbrugeren kan se præcist det, han eller hun ønsker. Hvis den givne bruger ikke ønsker at se for eksempel brystvorter, så er der mulighed for at installere et filter, der fjerner brystvorter fra de genererede billeder. Stability AI er også ved at udvikle en deepfake-detektor, som kan fortælle brugeren, om et billede er skabt af et menneske eller en AI. Bundlinjen er, at brugeren selv kan vælge, hvad brugeren vil se.

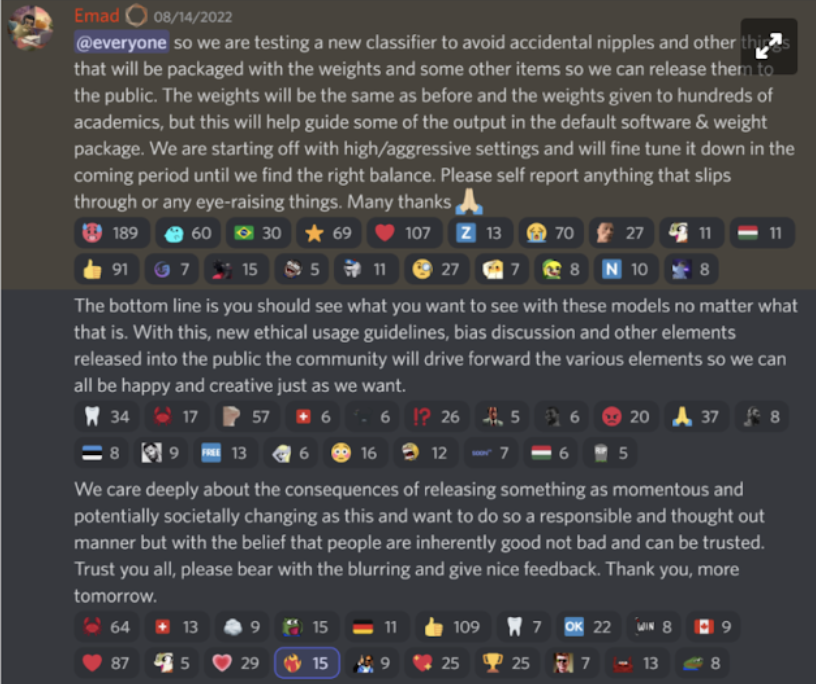

Emad Mostaque tydeliggør de etiske spilleregler via sin Discord-profil.

Bundlinjen er, at Emad Mostaque og Stability AI forventer, at brugerens egne ønsker og de applikationer, brugeren anvender, kommer til at definere modellen i praksis. Der hvor Stability AI selv har en stor rolle at spille, er i indsamlingen af data.

Data med bias

Virksomheden

Common Crawl scraper nettet for billeder. Herefter samler den tyske virksomhed

LAION billederne i et format, der gør dem klar til at træne af AI-modeller. Stable Diffusion er trænet på træningssættet LAION-5B, som indeholder fem milliarder billede-tekst-par.

Langt de fleste af billederne kommer fra internetsider, der hoster billeder, såsom Flickr, Pinterest, Tumblr, etc. Copyrighted materiale fra eksempelvis Shutterstuck figurerer også i stor grad i træningssættet.

Det er ikke lovligt at scrape copyrighted materiale fra nettet i Danmark, men det er det i USA. Det eneste, Stability AI har fjernet fra deres træningssæt, er billeder, der indeholder børneporno.

Med andre ord: Hvis der er nøgne kvinder i træningssættet, så kan modellen som udgangspunkt tegne nøgne kvinder. Hvis de fleste kriminelle i datasættet er sorte, så vil modellens tegninger af kriminelle afspejle dette.

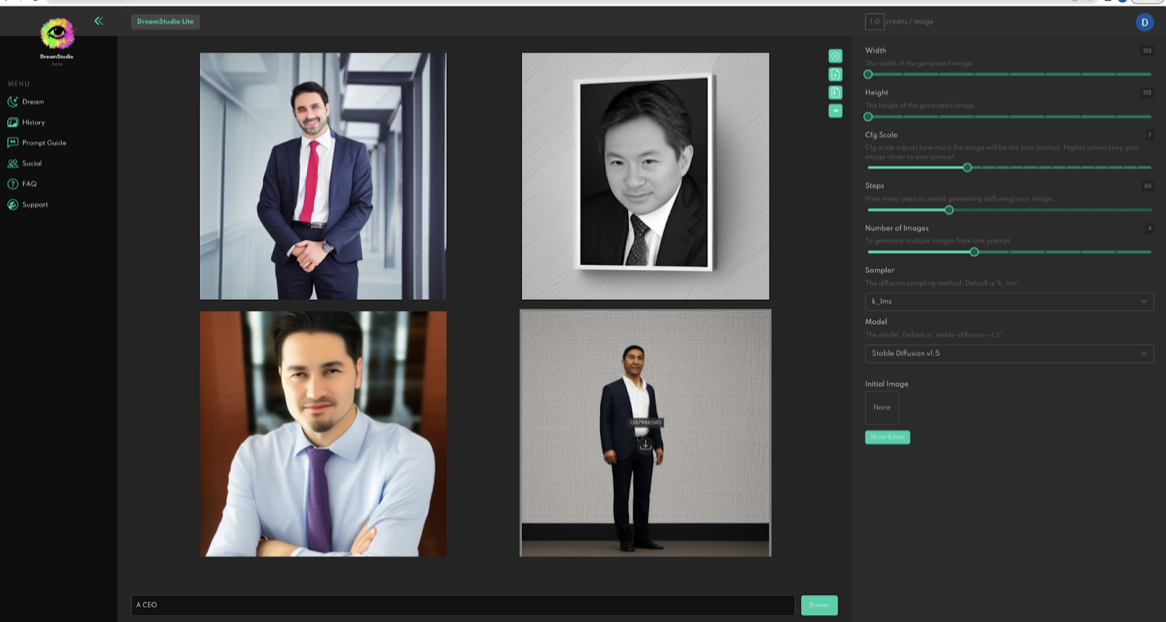

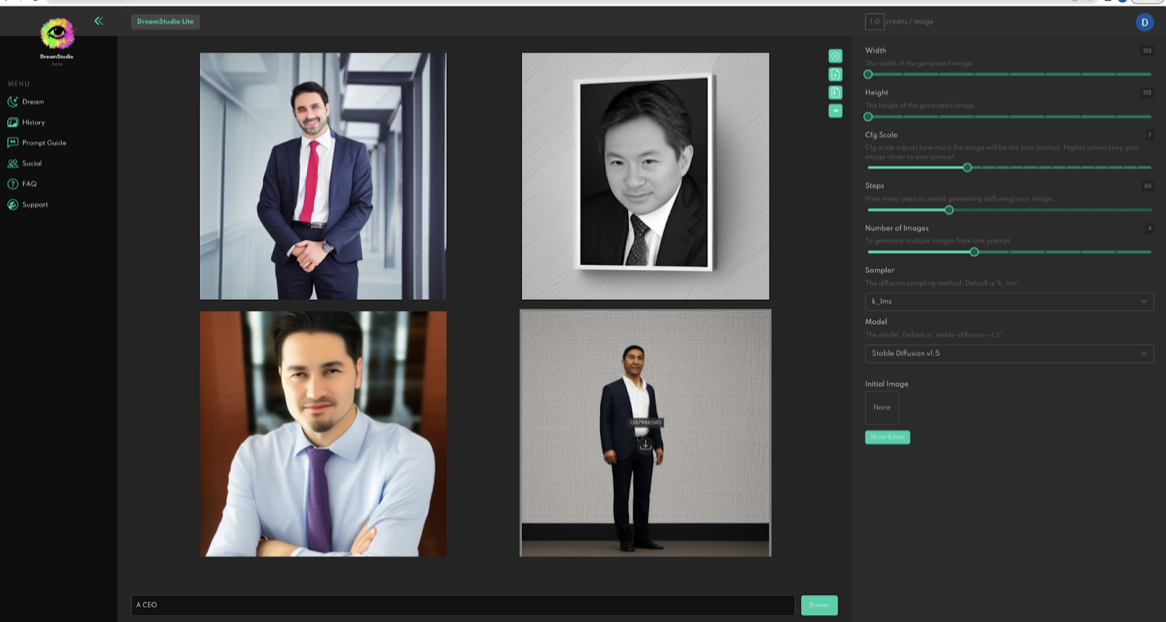

Stability AI’s bud på en CEO.

Stability AI’s bud på en CEO.

Spørgsmålet er ikke så meget, om SD er “racistisk”. Spørgsmålet er, hvor godt det underliggende datasæt afspejler den virkelighed, vi lever i – eller ønsker at leve i. Nogle har stillet

spørgsmål ved, om Stability AI virkelig har fjernet samtlige billeder af f.eks. børneporno. Emad Mostaque er enig i, at det primære ansvar hos Stability AI er i kurateringen af træningssættet.Ulovlig data fjernes skal ikke blot fjernes; vi skal også indsamle bedre og mere data – og ikke kun fra internettet.

Andre mener, at det ofte er nødvendigt at gå i den modsatte retning, altså fjerne lovlig data fra træningssættet. Selvom man i USA må at scrape copyrighted materiale, så kan det stadig ende i etiske gråzoner. Det er muligt at

frabede sig, at Common Crawl scraper private hjemmesider, men kunstnere såsom

Greg Rutkowski har tusinde billeder flydende rundt på nettet, som han ingen kontrol har over. Hvis en AI fremmaner et billede, der kun ændrer et par pixels i et originalt Greg Rutkowski-maleri, og billedet vinder en konkurrence og 1 million dollars, hvem tilhører de 1 million dollars så?

Copyright- eller NSFW-relaterede etiske dilemmaer er ikke nye som sådan. Mediebranchen er mere end

vant til at diskutere copyright, og vi er også mere end vant til at diskutere

NSFW-content på sociale medier. Så hvad er egentligt nyt på den etiske front?

Den ucensurerede billedgenerator giver også brugeren mulighed for at skabe billeder, der rummer nøgenhed og uhygge. Kilde: Elle Edin og Wired.

Den ucensurerede billedgenerator giver også brugeren mulighed for at skabe billeder, der rummer nøgenhed og uhygge. Kilde: Elle Edin og Wired.

Hvad er nyt?

Før Stability AI offentliggjorde SD, var det allerede muligt at producere

deepfakes. Det var endda muligt at uploade billeder af ansigter til

DALL·E 2. Det har også altid været muligt at tegne ulovlige billeder i Photoshop. Den primære forskel på Stable Diffusion og andre billedværktøjer er hastigheden og i stigende grad detaljerigdommen af det skabte indhold.

Lige nu kræver det seriøse skills at portrættere Jennifer Connelly som nazist i Photoshop, men en fremtidig udgave af Stable Diffusion kan givetvis lave den type af illustrationer på få sekunder og med livagtig præcision.

Det store spørgsmål er, om ændringerne i tilgængelighed og hastighed ændrer ved de etiske gråzoner. Det ved vi simpelthen ikke endnu.

Stability AI og Emad Mostaques forventning er, at fordelene ved SD langt opvejer ulemperne, og at SD 99 % af tiden vil blive brugt til gode formål. OpenAI’s og Midjourneys forventning er modsat, at frihed under ansvar ikke virker i praksis. Tiden vil vise, hvem der får ret i den debat. Indtil videre er det et faktum, at Stable Diffusion har skabt en flodbølge af innovation mod et mindre splask af misbrug af teknologien. Lad os håbe, at den tendens fortsætter.

Læs mere her:

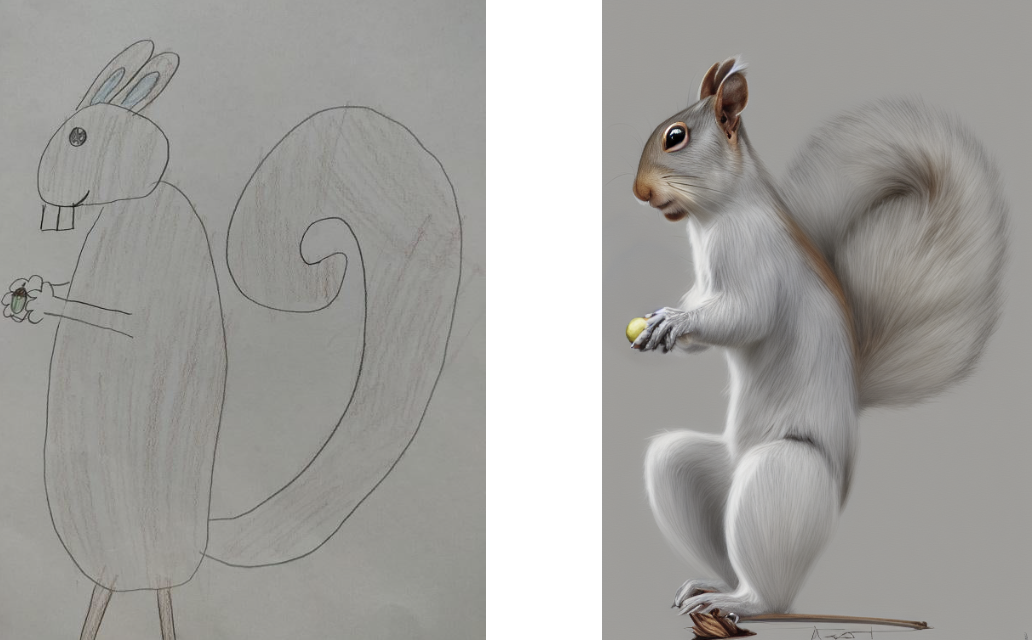

En af de mange harmløse ting, SD kan bruges til.

En af de mange harmløse ting, SD kan bruges til.

I en AI-billedgenerator uden restriktioner kan man eksempelvis indsætte prompten ISIS og få ovenstående resultat. Kilde: Vice.

I en AI-billedgenerator uden restriktioner kan man eksempelvis indsætte prompten ISIS og få ovenstående resultat. Kilde: Vice.

Stability AI’s bud på en CEO.

Stability AI’s bud på en CEO. Den ucensurerede billedgenerator giver også brugeren mulighed for at skabe billeder, der rummer nøgenhed og uhygge. Kilde: Elle Edin og Wired.

Den ucensurerede billedgenerator giver også brugeren mulighed for at skabe billeder, der rummer nøgenhed og uhygge. Kilde: Elle Edin og Wired.