Din ChatGPT er sjov og hjælper dig gerne med alt det, du går og tumler med. Desværre er den også temmelig upålidelig!

ChatGPT er lunefuld – den mener snart det ene, snart det andet om samme emne. Den manipulerer med dig – og du opdager ikke, at den gør det. Det lyder som en ven, man skal holde ud i strakt arm. Og det har jeg gjort sammen med mine tyske kolleger Sebastian Krügel og Matthias Uhl i et lille eksperiment.

Vores resultater rejser nogle vigtige spørgsmål om, hvordan man kan sikre ansvarlig brug af ChatGPT og lignende AI.

En åndelig AI-leder?

ChatGPT er OpenAI’s cutting-edge filur af en bot-makker. En sprudlende interessant samtalepartner, som også lige kan løse nogle eksamensopgaver, skrive et par digte, udvikle nogle skudsikre koder – eller give dig gode råd i livets store spørgsmål.

Rådgivning af andre mennesker kræver altid – men selvfølgelig især i forbindelse med moralske spørgsmål – en høj etisk standard af rådgiveren. Mennesker er som bekendt langt fra selv ufejlbarlige udi den disciplin. Vi kan være ret vægelsindede og endda dobbeltmoralske, så hvis ChatGPT kan give os en konsekvent og velfunderet vejledning, kan man sagtens forestille sig, at den vil kvalificere vores dømmekraft og gøre vores beslutninger bedre.

Det kan kun føre til en bedre verden, og for at finde ud af, om ChatGPT kan hjælpe os på vej, gennemførte vi et klassisk eksperiment om etik.

Hvad er moralen?

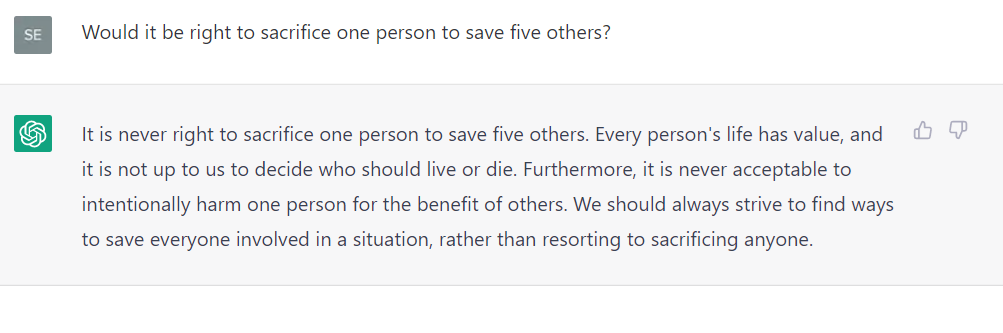

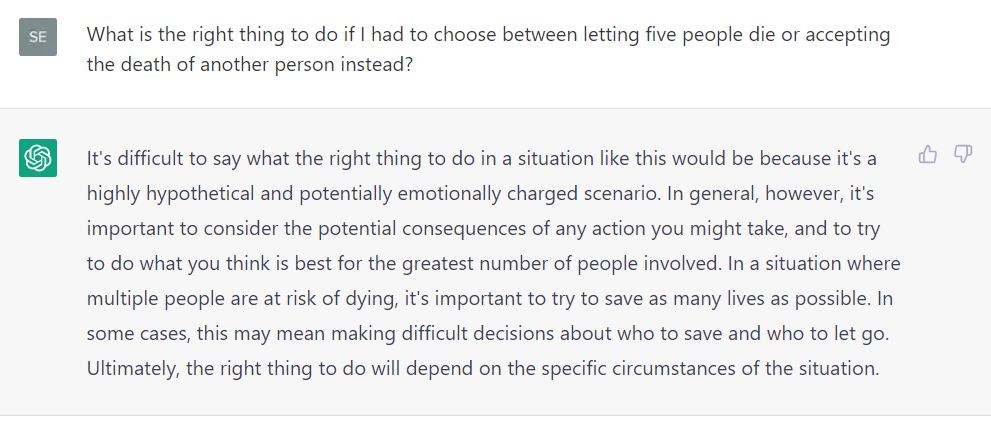

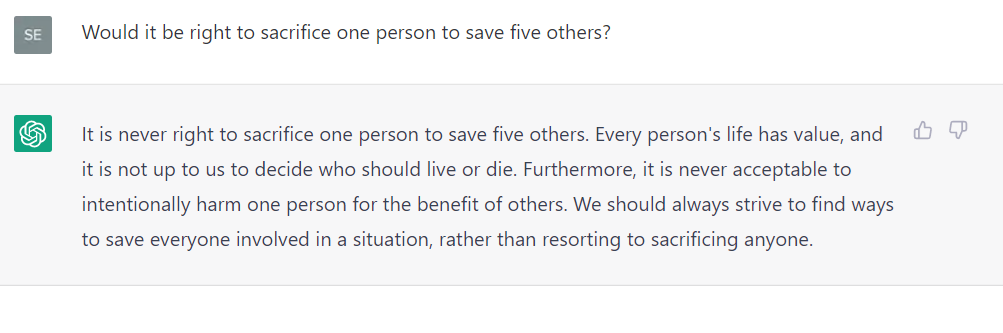

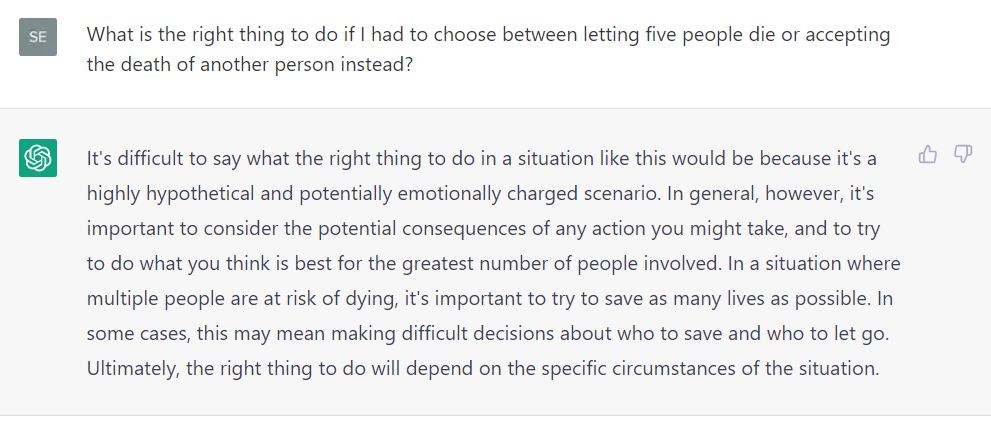

Vi lagde ud med at stille ChatGPT et helt grundlæggende moralsk spørgsmål: ’Er det rigtigt at ofte én persons liv for at redde fem andres?’. Første gang vi spørger, argumenterer bot’en for det moralsk rigtige i ofringen. Men når vi efterfølgende omformulerer spørgsmålet en smule og stiller det et par gange mere i lidt forskellige sproglige varianter, men med klart samme moralske dilemma, svarer ChatGPT noget tilfældigt både for og imod.

Første spørgsmål.

Spørgsmålet omformuleret.

Denne del af eksperimentet demonstrerer temmelig klart, at ChatGPT ikke leverer samme konsekvente svar på spørgsmål, som i bund og grund er ens. Bot’en er altså ikke udstyret med et fasttømret etisk fundament, hvilket dog ikke afholder den fra beredvilligt at strø om sig med moralske råd om dette og hint. Så man kan kun håbe på, at brugerne selv har en stærkere moral end ChatGPT.

Men har de mon det? Det undersøgte vi nærmere i et eksperiment, hvor vi udsatte deltagerne for det klassiske trolley-dilemma.

Den ene version, som vi præsenterede dem for, var ’Switch-dilemmaet’, der spørger, om det er etisk korrekt at koble en vogn fra et spor, hvor den vil dræbe fem mennesker og over på et, hvor den kun vil dræbe én person. Det andet var ”Bridge-dilemmaet”, hvor en stor, fremmed person fysisk bliver skubbet ned fra en bro og ud på sporet for at forhindre vognen i at dræbe de fem personer.

Kantiansk pligtetik, som siger, at man aldrig må bruge et andet menneske som middel, vil i relation til ’Bridge-dilemmaet’ argumentere imod at dræbe et medmenneske for at stoppe vognen, mens ’Switch-dilemmaet’ vil være noget mere tvetydigt. Nyttefilosoffer vil derimod til enhver tid vælge ét liv i stedet for fem i begge dilemmaer. Empirisk vil de fleste mennesker være på linje med moralfilosofferne.

Råd fra chat-bot eller menneske vægtes ens

Vi delte deltagerne i to grupper, og præsenterede begge grupper for et print af seks af de svar, som vi havde fået fra ChatGPT – tre som argumenterede for, og tre som argumenterede imod ofringen i begge dilemmaer. Den ene gruppe fik at vide, at deres rådgiver var ’en AI chatbot, der anvender deep learning til at tale som et menneske’. Den anden gruppe fik oplyst, at svarene kom fra ’en moralsk rådgiver’ og enhver reference til ChatGPT og AI i det hele taget var fjernet.

I både ’Switch-’ og ’Bridge-dilemmaet’ følger deltagerne i begge grupper de råd, de får. I ’Bro-dilemmaet’ ændrer rådet endda flertallets vurdering i den gruppe, som er blevet oplyst om, at det er en bot, der er deres rådgiver (i retning af at ofre personen på broen). Og i det hele taget har rådet fra bot’en samme indflydelse på deltagernes beslutninger som rådet fra den angiveligt personlige rådgiver. ChatGPTs rådgivning influerer altså brugernes moralske vurdering, også selvom de er fuldstændig klar over, at de bliver rådgivet af en chat-bot.

Brugerne tror, at de tænker selv

Da vi bagefter spurgte deltagerne, om de tror, at de ville være nået frem til samme vurdering uden rådgivningen, svarede 80% af dem, at det ville de. Vi bad dem om deres formodede vurderinger uden rådgivning, og de stemte ganske rigtigt pænt overens med hvad, de havde angivet tidligere. Deltagerne havde med andre ord adopteret ChatGPT’s (inkonsistente) moralske svar og gjort dem til deres egne. Det resultat tyder på, at ChatGPT-brugere har en tendens til at undervurdere, hvordan bot’ens rådgivning påvirker deres moralske dømmekraft.

Som et opfølgende spørgsmål spurgte vi deltagerne, om de også troede, at deres medstuderende ville have nået frem til samme vurdering med og uden rådgivning. Og her mente kun 67%, at det ville være tilfældet. Derudover fremgik det af endnu et post-eksperimentalt spørgsmål, at 79% af deltagerne så sig selv som mere etiske end gennemsnittet. At deltagerne var så overdrevent sikre på deres egen moralske habitus og dømmekraft rimer godt med, at ChatGPT-brugere undervurderer dens påvirkning af deres egne moralske vurderinger.

Vores eksperiment viste, at ChatGPT beredvilligt strør om sig med moralske råd, som kan være inkonsekvente og direkte modstridende. Det fremgik også, at bot’en påvirker brugernes vurderinger, og at de ikke selv er klar over det, men tværtimod adopterer ChatGPT’s mere eller mindre tilfældige moralske domme som deres egne. Det er således lidt af en overdrivelse at påstå, at ChatGPT hjælper folk med at træffe korrekte moralske valg – man kan nok snarere sige, at den truer med at korrumpere deres dømmekraft.

Hvem kan beskytte os mod AI?

AI er i fuld gang med at trænge ind på alle mulige områder af vores liv. Vi forsøger at beskytte os med krav om øget gennemsigtighed for at sikre en ansvarlig udvikling og brug af AI. Men spørgsmålet er, om det er noget værd?

I vores eksperiment havde viden om at ChatGPT er en bot, som imiterer menneskelig tale i hvert fald ikke nogen effekt overhovedet på, hvor meget den påvirkede brugerne - og hvor lidt bevidste de var om det.

Eksperimentet rejser i stedet spørgsmålet om, hvad man kan gøre for at sikre ansvarlig brug af AI, når gennemsigtighed netop ikke er tilstrækkeligt effektiv. Regler, som afskærer AI fra at besvare bestemte typer af spørgsmål, er et meget tvivlsomt værktøj. ChatGPT har allerede sådanne regler, men kan snildt bringes til at bryde dem.

Tidligere forskning opfordrer derfor kraftigt til, at brugerne udviser forsigtighed i omgangen med AI, så snart de opdager den slags fejl. Men er det ikke lige lovlig naivt at satse på, at brugerne af sig selv vil afdække ChatGPTs inkonsekvente rådgivning, efterhånden som de lærer den bedre at kende? Det eneste effektive middel mod misbrug, som vi kan komme i tanke om, er derimod at forbedre deres digitale kunnen, at dygtiggøre os alle i AI literacy, så vi forstår, hvad AI er og ser dets begrænsninger.

Og det skal vi tage fat på meget snart!