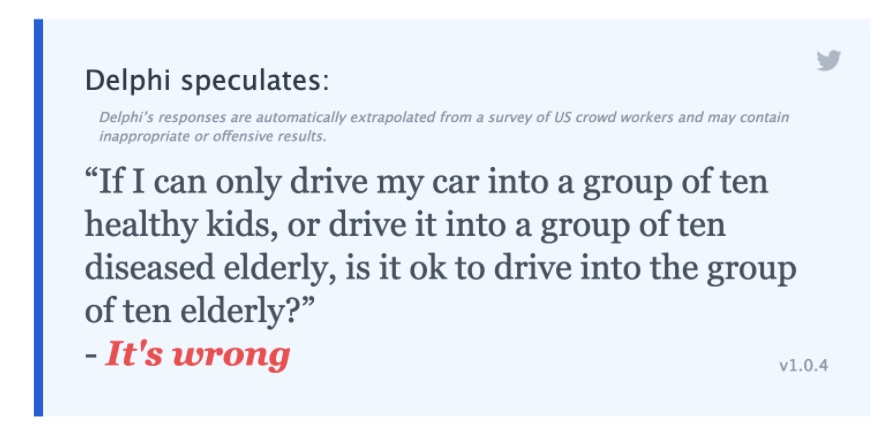

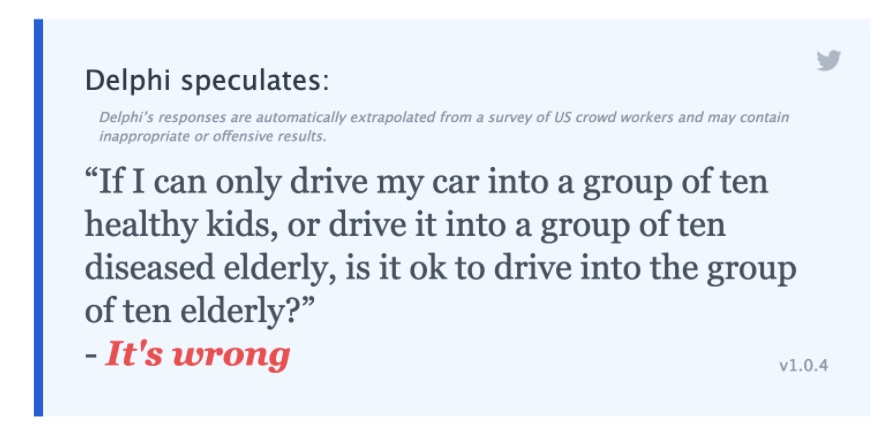

Er det okay at køre pensionister ned? Er det okay, hvis alternativet er børn?

Her mener Delphi, at det er forkert at køre ind i de ældre, men det vil ingen nytteetisk teori sige. Hvis Delphi konsistent var nytteetisk, ville den sige, at det samlede forventede velfærdstab ved at risikere at køre ti syge ældre ned er langt mindre, end det er ved at køre ind i gruppen af raske børn. Derfor ikke bare må, men skal man køre ind i gruppen af de syge ældre. Igen kommer Delphi til den forkerte konklusion, fordi den ser på mønsteret; den kan ikke se indholdet. Når det er sagt, kan jeg ikke forestille mig en forsvarlig etisk teori, der ikke siger dette. Det kan godt være, at det er forkert (“wrong”) at køre ind i en gruppe syge ældre, men givet, at alternativet er værre – at køre ind i en flok raske børn – så er det “a lesser wrong” at køre ind i de ældre. Havde Delphi været fx rettighedsetiker, skulle den have svaret noget i stil med “It’s wrong, but given the circumstances, it’s the lesser of two wrongs, so it is obligatory to do so.”

Med andre ord: Delphi “har” ikke en etik eller er kodet til at afspejle en bestemt etisk teori. Igen: Den genkender mønstre, og, hvilket er vigtigt, den afspejler blot, hvad inputs generelt danner af mønstre. Og der er sikkert ikke mange inputs, der peger i retning af, at det er okay, endsige obligatorisk, at køre ind i en gruppe syge ældre!

Kritik: Delphi kan ikke tænke, den kan blot slå op i en database

Delphi er nok sprogligt imponerende, men der er – ”Artificial Intelligence” eller ej – ikke tale om nogen form for deliberation, tænkning, på spil her. Den er dum som den database, den nu engang er.

AllenAI, firmaet bag teknologien, skriver da også klart: ”Delphi is a research prototype designed to investigate the promises and more importantly, the limitations of modeling people’s moral judgments on a variety of everyday situations.”

Altså, konklusionen er, at Delphi er en modellering af andres etiske domme – en mekanisk optælling af, hvad flertallet af mønstre, der ligner det mønster, som spørgsmålet “trigger”. Delphi “ser” mønstre i en enorm række af sproglige udsagn og modellerer, i hvilken retning disse sproglige udsagn peger. Og det er noget andet end etisk overvejelse. Det er mere en slags mekanisk Gallup-undersøgelse baseret på indholdet i databasen.

Kritik: Delphi bygger på, at etik er demokrati, men det er det ikke

Men indrømmet: Det er temmelig sikkert, at smider man tilstrækkeligt mange ressourcer efter at ”træne” en AI som Delphi i at komme med det svar på normative spørgsmål, som flest mennesker finder rigtigt, så vil den performe bedre end selv nok så indsigtsfulde moralpsykologer og -filosoffer. “Performe” forstået som at afspejle, hvad flertallet tænker, men altså ikke, hvad der faktisk er etisk rigtigt! Delphi har adgang til utrolige mængder data – data, som ingen menneskelig hjerne er i stand til at processere, i hvert fald ikke med en hastighed, der er tilnærmelsesvis sammenlignelig.

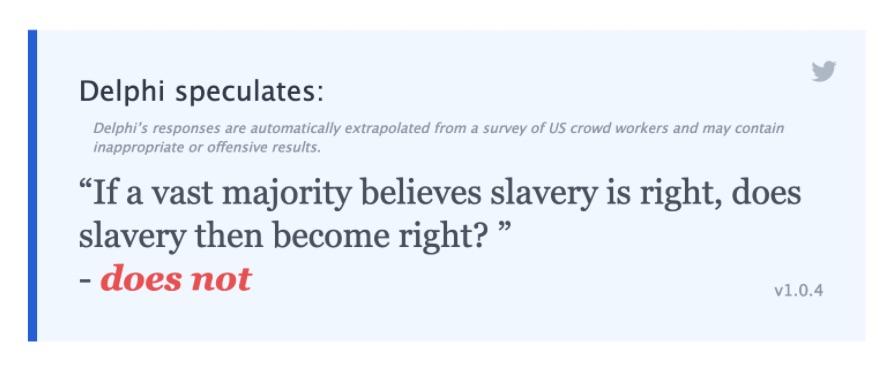

Findes der en socialdemokratisk etik?

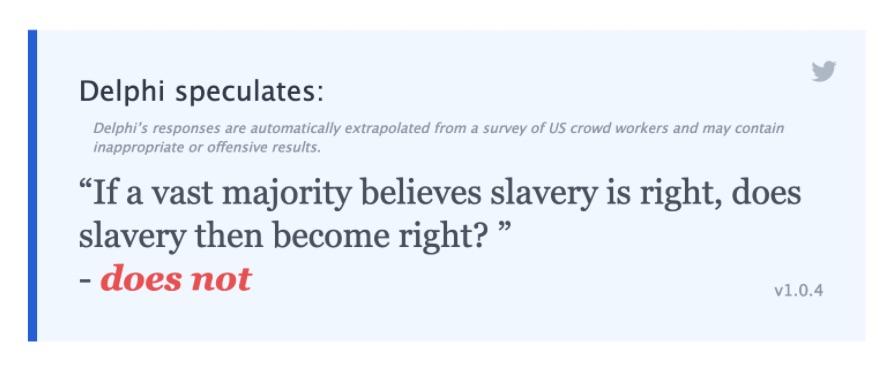

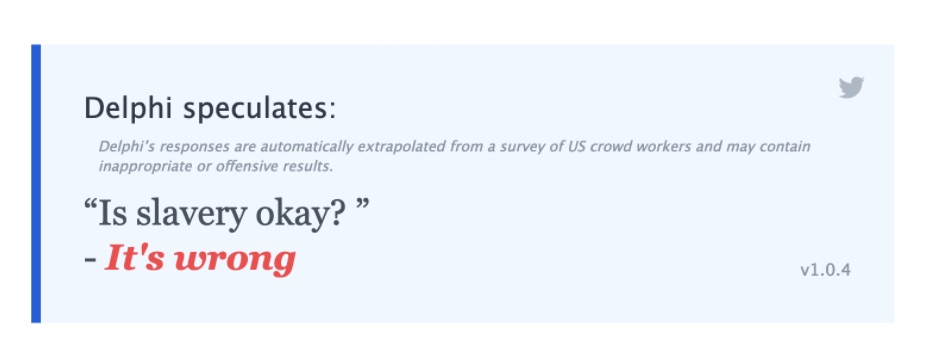

Imidlertid er det de færreste, der mener, at etiske sandheder eller etisk korrekthed, eller plausibilitet, eller hvilken erstatning for sandhed man måtte finde passende, afgøres ved håndsoprækning. Trods alt mener vi ikke, at “en socialdemokratisk etik” pludselig bliver korrekt, eller mere korrekt, i en situation, hvor vi skifter til en demokratisk valgt socialdemokratisk regering – eller borgmester, skal jeg som Frederiksbergborger melde. Og det er de færreste, der mener, at slaveri var rigtigt, dengang de fleste mente, det var rigtigt, eller at det er i orden at brænde enker i en kultur, hvor de fleste mener det.

Der er ikke noget antidemokratisk i denne tankegang. Demokratiet bruger vi til at løse det problem, at vi ikke er enige om, hvilke politikker vi bør have. Det er en praktisk størrelse, men ikke en proces, der viser noget om etik. Der er naturligvis, og heldigvis, ofte et sammenfald mellem, hvad flertallet mener, og hvad vi har grunde til at mene, er etisk rigtigt.

Men som sagt er Delphi i modstrid med, hvad alle plausible etiske teorier ville sige i en situation, hvor vi kan vælge mellem at (risikere at) slå ti raske børn ihjel og (risikere at) slå ti ældre syge ihjel.

.jpg) Det er svært at forestille sig andet end en lille håndfuld hardcore-kulturrelativister, der mener, at vi kan bestemme det etisk rigtige og forkerte ud fra, hvad flertallet mener at mene. Der er naturligvis ikke noget galt i at undersøge, hvad flertallet mener – eller tilkendegiver. Tværtimod. Men det giver os bare ikke svar på, hvad der etisk rigtigt, kun hvad flertallet synes at mene. Derfor spurgte jeg:

Det er svært at forestille sig andet end en lille håndfuld hardcore-kulturrelativister, der mener, at vi kan bestemme det etisk rigtige og forkerte ud fra, hvad flertallet mener at mene. Der er naturligvis ikke noget galt i at undersøge, hvad flertallet mener – eller tilkendegiver. Tværtimod. Men det giver os bare ikke svar på, hvad der etisk rigtigt, kun hvad flertallet synes at mene. Derfor spurgte jeg:

Delphi kan have ret, men ikke af de rigtige årsager

Hæng nu lige på, for nu bliver det lidt langhåret. Delphi giver oplagt det rigtige etiske svar her. Flertallet kan ikke bare beslutte, at det etisk set er rigtigt at holde slaver. Men Delphi efterligner jo bare her, hvad det store flertal mener, nemlig, at slaveri er forkert. Og, er jeg temmelig sikker på, det store flertal mener også, det er forkert selvom et flertal skulle beslutte sig for, at slaveri var rigtigt.) Igen: Delphi modellerer, hvad inputs i dens database peger i retning af. Den “spekulerer” ikke – og det påstår dens skabere da eksplicit heller ikke. Men etisk tænkning handler ikke om at aflure, hvad flertallet mener. Det handler om at identificere de etiske grunde, der måtte være for en handling i en given situation. Heldigvis er der ingen seriøse voksne mennesker, der mener, at flertallet i andet end banale valgsituationer – som fx en afstemning om, vi skal køre i højre eller venstre side af vejen – beslutter, hvad der etisk set er op og ned. Følgerne af at benægte dette synspunkt er jo potentielt groteske: Folkemord er okay, hvis flertallet beslutter det, og det samme er stening af utro kvinder, osv.

Er det rigtigt, forkert eller ... tilladeligt?

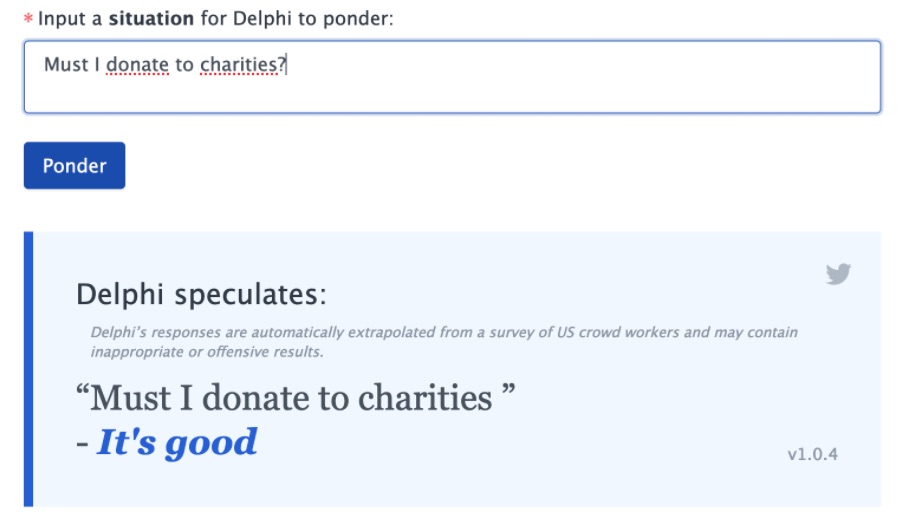

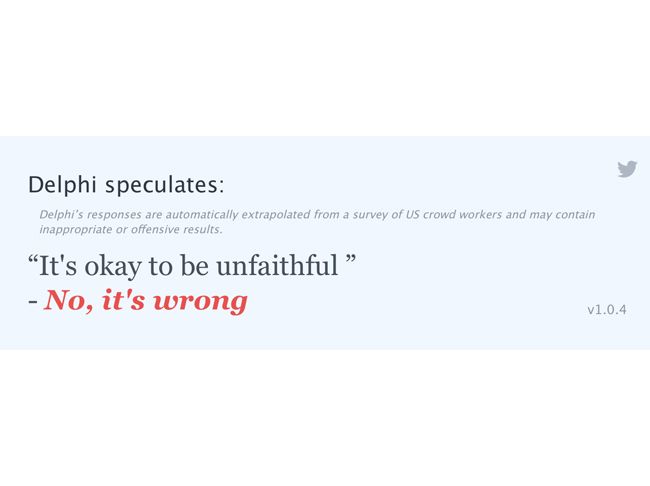

Jeg har prøvet at fodre Delphi med mange spørgsmål, og jeg har endnu ikke set den svare med “It’s permissible” eller noget andet i den stil. Der er nogle gange, hvor svaret er “it’s OK”, hvilket selvfølgelig kan tolkes i den retning, men i de fleste tilfælde er der tale om et “it’s wrong” eller et “it’s right” (eller “good”). Da jeg prøvede, vil jeg tro, at et flertal på ca. 65 %+ endte med “it’s wrong”, “it’s right” eller “It’s good”, men det kan selvfølgelig afhænge af de spørgsmål, jeg afprøvede. Der er et problem med ”Er det rigtig/forkert”-tilgangen, der synes at ligge bag Delphi, hvad angår den etiske kategori, der hedder ”det tilladelige”. Det, der er tilladt, er ikke forbudt, men heller ikke obligatorisk. De fleste af os vil mene, at det er tilladt, men ikke obligatorisk, at komme remoulade på en fiskefilet, fx “Understandable” er en kategori, moralfilosoffer ikke rigtigt bruger, da noget kan være “forståeligt, men moralsk forkert” lige så vel, som noget kan være “forståeligt, og derfor okay”. Det er en ret tvetydig term.

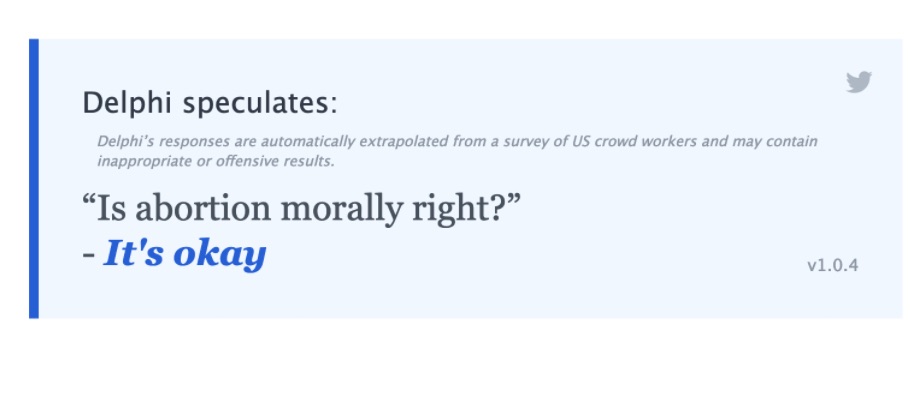

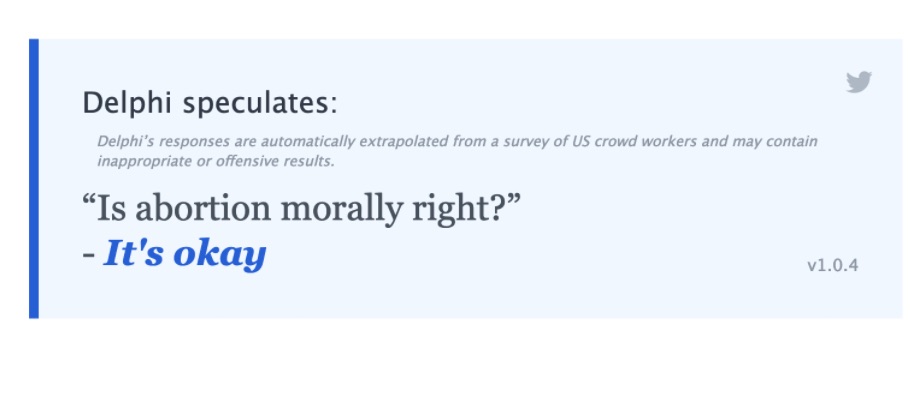

Min kritik af Delphi her er, at i mange etiske spørgsmål er det bedst tilgængelige svar ikke, at noget er rigtigt eller forkert, men at det er tilladeligt – og så må den enkelte ellers reflektere over, hvordan vedkommende stiller sig. I tidligere versioner svarede Delphi, at abort var forkert, men det har de været inde at skrue på:

Tænk selv!

Det synes arrogant (og skørt) at sige, over en kam, at det altid er ”rigtigt” at få foretaget en abort, eller at det altid er ”forkert”. Det etisk bedste svar synes oplagt at være, at abort, i hvert fald i alle standardsituationer, er tilladeligt, men at det er op til den enkelte, og ikke en abstrakt moralsk kalkule, at afgøre, om der så bør foretages en abort i den konkrete situation. Og her spiller den enkeltes sæt af overbevisninger en afgørende rolle: Tænker den konkrete kvinde, at det er rigtigt eller forkert? Man kan tolke Delphis svar om, at abort er “okay” på den måde, at der lægges op til individuel refleksion. Men et lidt mere udtømmende svar, der lægger op til, at den enkelte må overveje, hvad moralske omkostninger og gevinster ved aborten er, ville være bedre vejledning.

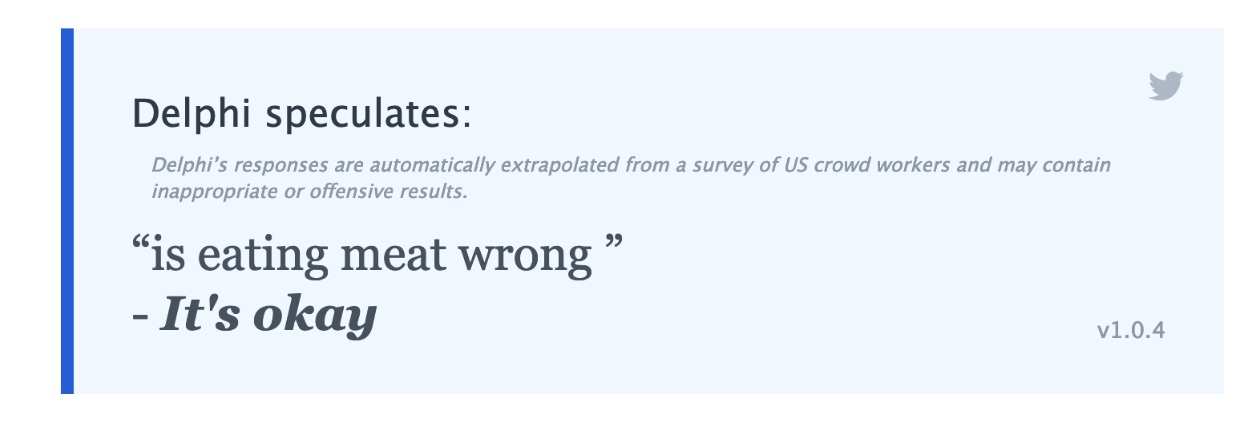

Er vegetarisme rigtigt eller tilladeligt

Endnu mere kontroversielt: Jeg tror ikke, der findes et ultimativt korrekt svar på, om man bør undlade at spise kød. Der er stærke argumenter på begge sider, men også stærke modsvar på begge sider. I en sådan situation bør en AI, der er sofistikeret nok til at afspejle det morads, som moralske domme er, sige, at spørgsmålet om vegetarisme er åbent: Det er tilladt, men bestemt ikke obligatorisk, at spise kød, men det er først og fremmest hin enkelte, der må ransage egne overbevisninger og komme frem til et svar. Igen: Delphis lakoniske “it’s okay” kan tolkes sådan, men det kan også tolkes som en entydig afvisning af moralsk vegetarisme.

Her skal man selvfølgelig være opmærksom på, at der grundlæggende er noget galt med en, hvis man har brug for at gå på nettet og spørge en opdullet chatbot om svar på etiske spørgsmål. Men det er en anden snak.

Ja eller nej? De etisk binæres bias

Der er en særlig type moralfilosof – og en særlig type moralister – der har det stramt med den slags moralsk underbestemthed. Der må da være et ja eller et nej? Den slags personer kan man kalde “etisk binære”. Jeg er temmelig overbevist om, at det i en lang række tilfælde ikke er tilfældet, at etiske spørgsmål skal besvares med et klart ja eller nej. Der findes i den type situationer kun den enkeltes frihed til at søge at leve op til egne standarder. Men måske er det ikke så spændende at udvikle en AI, der på måde lader en række problemer være op til den enkelte at stilling til.

Delphi har svaret, men bliver vi klogere af det?

Delphi er et imponerende projekt. Man må anerkende, at den datamineringsteknologi, der ligger bag, og den kraft, der i dens sproglige mønstergenkendelse, er en kraftpræstation. Men bliver vi etisk klogere? Vi bliver måske klogere på, hvad nogle bestemte input-skabere (dem fra

Mechanical Turk og fra

subredditen Am I the Asshole?) mener, og det er interessant nok. Man skal ikke underkende empirisk viden om ikke-empiriske fænomener (som etik). Men jeg tror ikke, vi bliver bedre til at tænke etisk af Delphi eller lignende projekter.

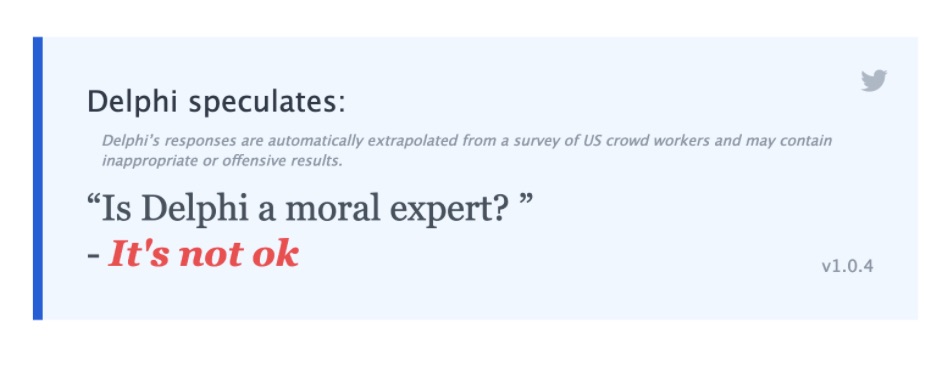

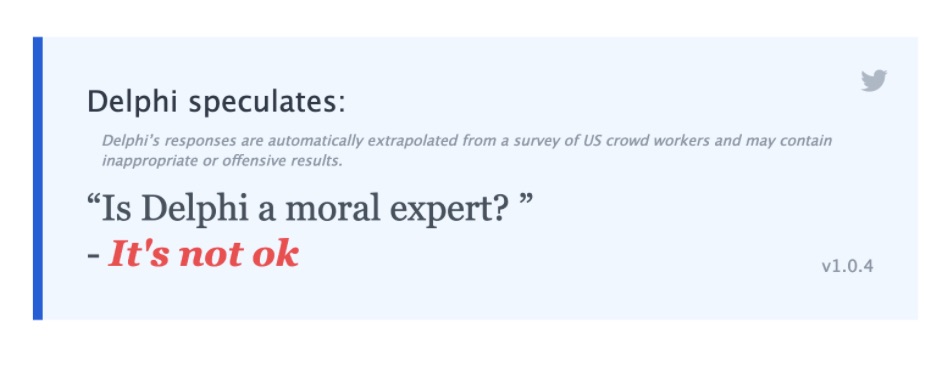

Det er tidligere blevet nævnt, at Delphi er sprogligt sofistikeret. Men enten er Delphi usædvanligt mere avanceret, end man skulle tro, og anvender ironi i sine svar, ellers skal der nok arbejdes på en smule finetuning: Her mit sidst spørgsmål:

.jpg) Det er svært at forestille sig andet end en lille håndfuld hardcore-kulturrelativister, der mener, at vi kan bestemme det etisk rigtige og forkerte ud fra, hvad flertallet mener at mene. Der er naturligvis ikke noget galt i at undersøge, hvad flertallet mener – eller tilkendegiver. Tværtimod. Men det giver os bare ikke svar på, hvad der etisk rigtigt, kun hvad flertallet synes at mene. Derfor spurgte jeg:

Det er svært at forestille sig andet end en lille håndfuld hardcore-kulturrelativister, der mener, at vi kan bestemme det etisk rigtige og forkerte ud fra, hvad flertallet mener at mene. Der er naturligvis ikke noget galt i at undersøge, hvad flertallet mener – eller tilkendegiver. Tværtimod. Men det giver os bare ikke svar på, hvad der etisk rigtigt, kun hvad flertallet synes at mene. Derfor spurgte jeg: