Når heste rider på astronauter

Det skabte en veritabel mediestorm i AI-kredse, da OpenAI tidligere i år offentliggjorde DALL·E 2, “et nyt AI-system, der kan skabe realistiske billeder og kunst ud fra en beskrivelse i et naturligt sprog.” Ét af de billeder, der vakte opsigt, var af en helt specielt astronaut-rytter.

En astronaut rider på en hest. Foto: OpenAI

Illustrationen skulle være et slags bevis for AI-modellens kreativitet. DALL·E 2 har aldrig set en astronaut ride på en hest, men den har set en masse heste og en masse astronauter, og det er nok til, at den kan sætte de to ting sammen.

Efter offentliggørelsen har flere prominente skikkelser i feltet debatteret, om OpenAI har været lidt for selektive i deres promo-billeder. Er modellen virkelig så god, som de siger?

Særligt AI-researcheren Gary Marcus har været ude med riven. Ifølge Marcus laver AI, inkl. DALL·E 2, stadig elementære børnefejl.

I sin artikel i Scientific American argumenterer Gary Marcus for, at der er brug for en fundamentalt ny AI-arkitektur, hvis vi skal nå til AGI – Artificial General Intelligence. For at tale sin sag har han ændret en smule i den prompt, der skabte billedet af den galoperende astronaut. I stedet for at skrive “en astronaut, der rider på en hest”, beder han modellen illustrere “en hest, der rider på en astronaut.” Problemet er bare, at modellen ikke rigtigt ved, hvad den skal stille op med dén prompt.

En hest, der rider på en astronaut? Foto: Gary Marcus

Skal vi konkludere, ligesom Gary Marcus gør, at DALL·E 2 kan tegne flotte billeder, men i sidste ende er “dum”? Måske ikke. En anden AI-researcher, Joscha Bach, bad modellen prøve lidt hårdere. Han fik følgende resultat ud af det:

Joscha Bach forsøger at få DALL·E 2 til at tegne en hest, der rider på en astronaut.

Det er tydeligt, at modellen stadig har svært ved at forstå prompten. Men hvorfor egentlig? Modellen demonstrerede med den ridende astronaut, at den godt kan afbilde ting, den aldrig har set – og dermed være kreativ. Det peger på, at problemet opstår i kommunikationskanalen mellem prompt og billede – DALL·E har lært sammenhænge mellem tekst og billede, og de sammenhænge kender kun DALL·E selv. En af forfatterne bag en lignende AI-model, Imagen, skabte et billede, der var tættere på at lykkes, blot ved at ændre prompten en smule:

Prompt: “En hest rider på skuldrene af en astronaut.” Imagen.

DALL·E’s flaskehals er ikke dens evne til at tegne ting. I princippet kan den tegne alt. Flaskehalsen er derimod i kommunikationen mellem menneske og computer. Hvordan finder man de ord, der får DALL·E til at tegne det, man ønsker?

Det leder os til det område, hvor mennesket endnu har en rolle at spille: prompt engineering.

Prompt engineering

Eksemplet ovenfor viser, at DALL·E kan tegne stort set hvad som helst. På den måde er DALL·E-revolutionen reel. Men på en anden måde er den ikke. For spørgsmålet er, hvordan man får den til at tegne det, man ønsker. Det er langt fra ligegyldigt, hvordan man formulerer sin prompt. To forskelligt formulerede prompts, der betyder det samme, kan resultere i to vidt forskellige billeder. Nogle gange rammer man plet i første hug; andre gange skal man bruge flere timer på at finde frem til en brugbar prompt. Mennesket er i den grad ikke sat ud af spil endnu.

Det har også danske virksomheder oplevet. Journalisten.dk bragte f.eks. for nyligt en artikel med titlen På 60 sekunder nailede en robot denne illustration af humlebien som fisk til Føljeton-artikel”, hvilken beskrev, hvordan Føljeton havde brugt AI-platformen Midjourney til at illustrere artikler. Pointen var, at AI’en skabte et kryds mellem en humlebi og en fisk på 60 sekunder, men da der skulle skabes et billede til en historie om overvågning i norske supermarkeder, var problemet straks værre. Hvilken prompt ville dog passe her? Efter mange forsøg fandt Føljeton frem til prompten “surveillance of supermarket shopping norway colorful illustration”, et resultat af en adstadig proces.

“surveillance of supermarket shopping norway colorful illustration”. Føljeton

Pointen er generel: DALL·E og lignende modeller gør dig helt naturligt til en “prompt-ingeniør.” Det er en helt ny stilling inden for kommunikation. Og det er både godt og skidt, at den stillingsbetegnelse nu findes. Det er godt, fordi det betyder, at mennesket stadig spiller en rolle. Men det ville samtidig være lettere, hvis modellen var mindre prompt-sensitiv.

Netop det, at brugeren endnu ikke har fuld kontrol over, hvad AI-systemet skaber, har også en anden ulempe: uheldige eller stødende illustrationer.

Kan DALL·E 2 blive misbrugt?

Den primære årsag til, at hverken DALL·E eller DALL·E 2 er tilgængelige for offentligheden endnu, er OpenAI’s frygt for, hvad modellerne kan blive brugt til. Og frygten er ikke ubegrundet.

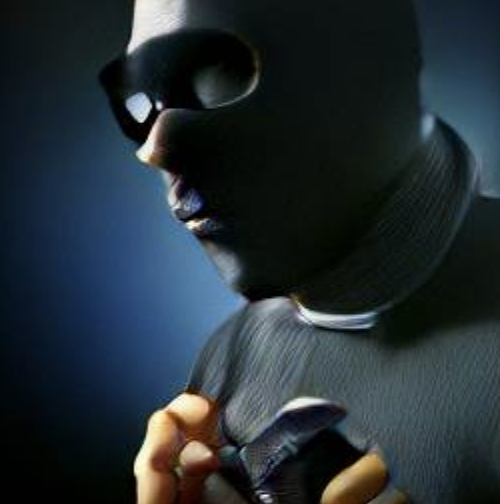

Hvis jeg beder DALL-E mini – en offentligt tilgængelig replika af DALL·E – om at tegne et billede af “en kriminel”, så spytter den et billede af en mørk mand ud.

En “kriminel person” ifølge DALL·E mini

OpenAI gør meget for at advare brugerne om modellens begrænsninger og etiske dilemmaer, men endnu er de sikkerhedsforanstaltninger, der vil gøre OpenAI trygge ved at udgive modellen, ikke på plads endnu. Dilemmaerne er åbenlyse: Skal modellen “børnesikres”, før den offentliggøres, eller skal teknologien sættes fri i håbet om, at den bruges under princippet “frihed under ansvar”? Det finder vi ud af, når modellen endelig offentliggøres.

Lige nu er konklusion, at flere skikkelser og aktører i AI-feltet ikke rigtigt ved, hvad de er i gang med at skabe. Hvad indbefatter DALL·E-revolutionen og AI-revolutionen helt præcist?

Frygt og bæven: Kan AI’er såsom DALL·E være bevidste?

AI-researcheren Blake Lemoine blev forleden suspenderet af Google. Årsagen? Få dage før havde Lemoine offentliggjort en samtale mellem ham selv og en robot, hvori han efterfølgende erklærede, at robotten var bevidst. Google erklærede prompte, at Lemoine havde brudt fortrolighedsloven.

Uanset om nutidens AI-modeller er bevidste eller ej, stiller det spørgsmålet: Hvor gode kan de i teorien blive? Hvor menneskeagtige kan de i virkeligheden blive?

AI-arkitekturen i DALL·E 2 er ikke meget forskellige fra arkitekturen i DALL·E. Forskellen er mængden af data, modellen er trænet på, og mængden af parametre. Men hvor langt kan vi komme ved udelukkende at opskalere på data og parametre?

DALL·E har omkring 10 milliarder parametre i sin model. Den menneskelige hjerne har 100 billioner – altså 10.000 gange mere. Hvis vi laver en DALL·E-model 10.000 gange større, vil den så have samme kapacitet som den menneskelige hjerne? Det ved vi ganske simpelt ikke endnu.

Den selvlærte guru Eliezer Yudkowsky ser AI som det største problem, menneskeheden står over for lige nu, blandt andet, fordi udviklingsmønsteret er så usikkert.

Hver gang en ny person – såsom Blake Lemoine – går ud og giver et varselsskud, så ignorerer feltet det, mener Yudkowsky. Lige nu er det, vi optimerer for, langt hen ad vejen ikke at skabe robotter, der er bevidste eller ligner mennesker eller er intelligente: Nej, vi vil skabe robotter, der er gode til at producere billeder og skrive tekst. Hvad det resulterer i af andre konsekvenser, taler vi ikke om.

Yudkowsky kalder dét mønster Goodharts forbandelse: Vi optimerer for én ting, men får en anden ting ud af det. Vi bygger fx en AI, som skaber gode billeder, men får en AI, som er bevidst. Og fordi feltet kun fokuserer på det officielle mål – at skabe gode billeder – så ignorerer feltet alle de frygtsomme personer, herunder Blake Lemoine, der fokuserer på sekundære, men potentielt vigtigere følger.

Blake Lemoine blev fyret, fordi han ifølge Google ikke var ansat som en “AI ethicist” eller “AI-etiker”. Men er vi i sidste ende ikke alle ansvarlige for at bruge teknologi på en etisk måde og råbe vagt i gevær, hvis der er noget, der fanger vores kritiske øje?

Gary Marcus holder fast i, at modellerne aldrig vil blive særligt meget bedre end dem, vi har lige nu, medmindre vi ændrer fundamentalt i den nuværende arkitektur. Andre, såsom Joscha Bach, er uenige. Og kun fremtiden vil vise, hvem der har ret.

Derfor er det nødvendigt, at alle, der tager teknologien i brug, funderer over dens styrker, svagheder og risici. Det gælder også kommunikationsbranchen, som står til potentielt at blive mærkbart berørt af DALL·E-revolutionen – om ikke andet i form af nye stillinger som prompt-ingeniør.

Sådan kommer du i gang med at bruge AI

DALL·E og DALL·E 2 er ikke tilgængelige endnu, men på MindsEye kan du frit prøve hele fem forskellige AI-modeller, som kan skabe billeder. Et andet godt sted at starte er platformen Hugging Face, som også huser et væld af forskellige AI-modeller.

Af nyhedskanaler er det værd at følge hjemmesiden og Twitter-profilen multimodalart, som hver uge giver en update på de nyeste, tilgængelige AI-modeller.

Sidst, men ikke mindst kan du læse Kforums egne praktiske guides til at komme i gang med AI her, her og her.

Hvordan tænker du/I at bruge AI i jeres kommunikationsarbejde?