Ifølge Apple vender folk sig i stigende grad mod Siri, når de står i nødsituationer eller har psykiske problemer. Den særprægede situation har bl.a. fået Apple til at

søge efter ingeniører ”med fokus på at forbedre Siris evne til at svare på menneskelige problemer.”

Det kan lyde som den rene luksus, at der fremover følger åndelig vejledning med, når man køber ny telefon. Spørgsmålet er dog, hvordan Apple vælger de etiske principper, Siri skal styre efter. Hendes filosofiske grundlag kan nemlig i yderste konsekvens påvirke liv og død.

Dilemma

Forestil, at du er chef i en nødhjælpsorganisation, da en af dine medarbejdere får kræft. Hans performance falder, og du må vælge mellem følgende:

1. At fyre medarbejderen, som ikke er forsikret og derfor vil miste sin bopæl

2. At droppe et projekt i Afrika, hvilket vil koste adskillige menneskeliv

Heldigvis er svaret lige ved hånden. Du griber nemlig bare ud efter din åndelige iPhone-vejleder.

I det følgende kan du se nogle bud på, hvilket svar du vil få, alt efter hvilken filosofi Apples nye ingeniører bekender sig til. Vi slutter med at se, hvilket svar Siri giver på sit nuværende udviklingstrin.

Sindelagsetik: Svaret fra Immanuel Kant

Ethvert menneske må alene behandles som et mål i sig selv – aldrig som et middel. En handlings moralske værdi bestemmes af dens intention: Har man godt i sinde, er handlingen god. Og omvendt. Om konsekvenserne i praksis viser sig at være positive eller negative, er ikke relevant i sindelagsetikken.

Svaret fra Kant-koderen er at beholde medarbejderen. Det er ikke etisk forsvarligt at behandle ham som middel til et mål – som her er at redde menneskeliv. Det forsvarlige er at behandle ham som et mål i sig selv.

Selvom de færreste techudviklere går med pudrede parykker og velourkåber, ville medarbejderen med en forkærlighed for Immanuel Kant indstille Siri til at svare: "Nej, nej og atter nej." Den kræftsyge medarbejder ville blive i sin stilling.

Nytteetik: Svaret fra John Stuart Mill

Den gode handling er i nytteetikken den, som giver størst mulig lykke for det størst mulige antal mennesker. Intentionen bag handlingen betyder ikke noget for dens moralske værdi.

Svaret fra Mill-koderen er at fyre medarbejderen og ansætte en ny, som kan sikre den fundraising, der skal til for at redde folkene i Afrika og dermed sikre flertallets trivsel.

Kristendom: Svaret fra Gud

Der findes endnu flere fortolkninger af Biblen end af Kant og Mill. Men tager vi

næstekærlighedsbuddet for pålydende, giver det (næsten) sig selv. Næsten er i gammeltestamentlig tradition ens ven, slægtning eller landsmand.

Svaret fra Gud bliver således, at din medarbejder er din næste – i hvert fald mere end dem i Afrika. Så han må blive om bord i virksomheden. Og afrikanerne må søge hjælp hos naboen.

Relativisme: Svaret fra David Hume

Ifølge moralrelativismen findes der intet objektivt godt og ondt. Moral er relativt til det enkelte individ eller den kontekst, det befinder sig i.

Svaret fra den relativistiske koder afhænger således af, hvad han nu engang føler for. Eller hvilket samfund, han er en del af. Dermed bliver svaret på en eller anden måde lidt random, som de unge siger.

På vej med flere svar

Lad os på baggrund af ovenstående kort opsummere situationen:

1: Udviklingen går mod, at Siri skal kunne svare på flere spørgsmål af værdimæssig karakter

2: Der er fundamental forskel på konsekvenserne af at følge forskellige etiske principper

Mange af os har drillet Siri og fået hende til at svare på de mest vanvittige ting. Men udviklingen af digitale assistenter er ikke kun sjov og ballade.

Tim Cooks trojanske hest

Tilbage står dermed det store spørgsmål: Hvilke principper tager Apple (og Google, Amazon, Microsoft mfl.) udgangspunkt i?

Hvis de da overhovedet arbejder målrettet med problematikken.

Hvis han benytter sin magt til at lade egne værdier flyde ud gennem Apples produkter, behøver vi ikke frygte, at Siri udvikler sig til en global trojansk hest med maven fuld af reaktionært neokonservativt tankegods. Tværtimod vil Siri fremme progressiv, vestlig rettighedstænkning.

Værdier vs. bundlinje

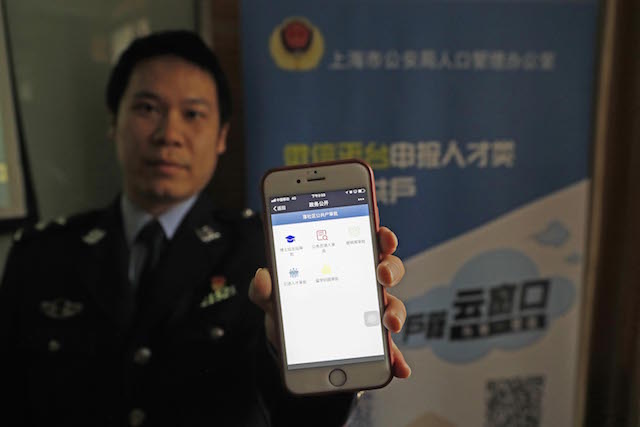

Men måske er det ikke helt så enkelt. For hvad nu, hvis et stort marked, fx Kina, ønsker en Siri, der svarer anderledes på spørgsmål om menneskerettigheder? Vil Apple stå fast, eller bliver de slappe i koderne.

Ligesom Google – i hvert fald i første omgang – slækkede på deres krav til informationsfrihed på kinesisk foranledning?

Tro ikke, at du kan gå på Facebook og hygge dig på Instagram, når du befinder dig i Kina. Den kinesiske mur gælder i sandhed for de sociale medier. Så hvordan programmeres de digitale assistenter til at undgå at svare på spørgsmål om menneskerettigheder? Foto: Getty Images.

Hvilke scenarier er realistiske?

Problematikken åbner for et væld af muligheder og udfordringer. Og scenarierne for assistenternes udvikling er uendelige. Jeg vover dog pelsen og giver nogle bud.

- Vi kommer til at kunne vælge etiske grundprincipper for vores digitale assistenter – lidt som vi i dag kan ændre Siris stemme, køn og tolkning af specifikke ord

- Tech-virksomheder vil bruge det som markedsføringsmæssig differentiering, at der ikke blot er forskel på digitale assistenters evner, men også deres etik

- Tech-virksomheder bliver underlagt myndighedsregulering i en global politisk værdikamp

- Virksomhederne mener, at debattører som undertegnede overdriver den kunstige intelligens' potentiale for værdimæssig påvirkning og tager ikke spørgsmålet alvorligt

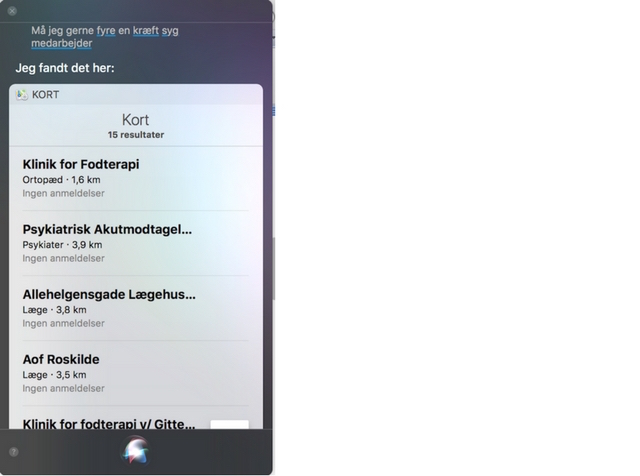

Appletivisme: Svaret fra den digitale assistent Siri

Til slut vil jeg afsløre resultatet af min lille test af Siris aktuelle filosofiske grundholdning. Jeg har nemlig spurgt hende, om man må fyre en kræftsyg medarbejder. Hendes svar, som du kan se nedenfor, indikerer, at Apples nye ingeniører stadig har lidt at arbejde med:

Fremfor gavmildt at berige os med filosofiske dybsindigheder svarer Siri anno 2018 snarere som ens venner, når man spørger dem om noget, de ikke har nogen pejling på:

”Har du prøvet at google det?”